Evaluierung des Risikos auf Basis der altersspezifischen Sterbewahrscheinlichkeiten ohne und mit Corona bei unterschiedlicher Kontakthäufigkeit

Steigende Fallzahlen sind keine Messlatte, denn Risiken sind immer relativ

Im Artikel „Gefahr Corona Virus – Wie groß ist das Risiko wirklich?“ wurde das pauschale Risiko, an COVID-19 zu erkranken und daran zu sterben anhand von 3 unterschiedlichen Kontaktprofilen näherungsweise bestimmt. Dabei wurde auch die Frage erörtert, wie sich das Sterberisiko mit dem Lebensalter und der Kontakthäufigkeit verändert und in welcher Relation das resultierende Gesamtrisiko zur allgemeinen Sterbewahrscheinlichkeit steht. Diese Aspekte wollen wir im Folgenden vertiefen und mittels Grafiken transparent darstellen.

Hinweis: Der eilige Leser kann sich mittels des Diagramms „Sterberisiko ohne und mit Corona in Abhängigkeit vom Lebensalter“ (s. Abb. 6., unten) und den Blick ins Resümee (am Ende des Textes, vor dem Quellenverzeichnis) einen schnellen Überblick verschaffen.

In der öffentlichen Diskussion und insbesondere auch in der Kommunikation des Robert-Koch-Instituts (RKI) stehen nach wie vor die absoluten Corona-Fallzahlen im Vordergrund. Es wurde schon von verschiedener Seite angemerkt, dass dies nicht hinreichend ist. Wenn jemand erzählt, er habe 10-mal die 6 gewürfelt, dann klingt das zunächst einmal nach viel. Das wird stark relativiert, sofern man erfährt, dazu seien 100 oder mehr Würfe nötig gewesen.

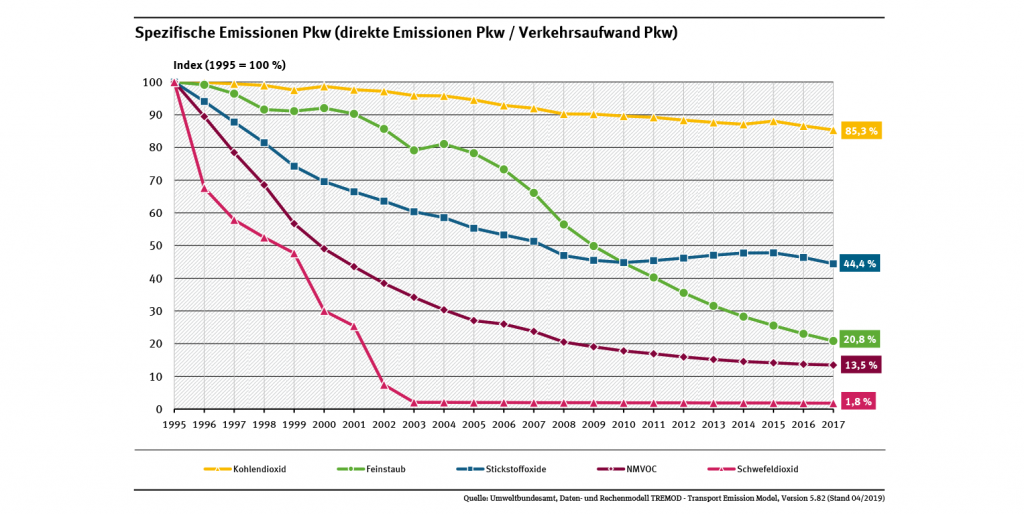

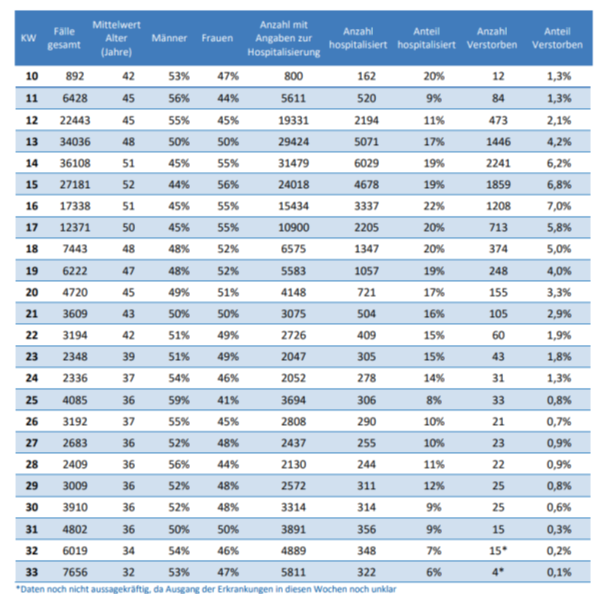

Da heute sehr viel häufiger getestet wird als zu Beginn der Pandemie, liegt es auf der Hand, dass auch mehr positive Befunde gezählt werden. Unabhängig von der Problematik der Falsch-Positiven Tests (also fälschlich als positiv erhaltende Testergebnisse, obwohl tatsächlich gar keine Infektion vorliegt, s. a. Gefahr Corona Virus – Wie groß ist das Risiko wirklich? ist daher die absolute Anzahl der positiven Tests kein vernünftiges Maß für die finale Beurteilung der Situation. Tatsächlich gibt auch das RKI die relativen Fallzahlen bekannt (s. Tabelle 1). In den Medien bleibt dieser relativierende und entschärfte Blick aber meist unerwähnt.

Tabelle 1: COVID-19 Positiv-Tests (Stand 2020-08-18). Quelle: RKI

Das Corona-Virus ist nur eines von vielen Lebensrisiken – es macht aber die beste Pressearbeit

Neben der relativen Positivenrate, die aktuell unter 1% liegt, ist der entscheidende Punkt die Ableitung des resultierenden Infektionsrisikos und die Beurteilung des daraus folgenden tatsächlichen Risikos für Infizierte in der Relation zu den allgemeinen Lebensrisiken. Fraglos ist das Leben grundsätzlich nicht risikofrei, wie auch immer man sich vor Gefahren schützen mag. Es ist daher eine unzulässig verkürzte Sicht, die vom Corona-Virus ausgehende und zweifellos tatsächlich bestehende Gefahr völlig isoliert zu betrachten und im Ergebnis dann fast schon als das einzige Krankheits- und Lebensrisiko wahrzunehmen.

Die Berichterstattung in den Medien zeichnet vielfach genau dieses Bild. Bei den Menschen bleibt dies nicht ohne Wirkung. Im Ergebnis wird die tatsächliche Gefahr durch das Corona-Virus in teilweise grotesker Weise überschätzt. Eine weitaus größere Gefahr geht z.B. Krankenhauskeimen aus. Jahr für Jahr sterben etwa 40.000 Menschen daran, ohne dass dies eine allgemeine Aufregung auslösen würde.

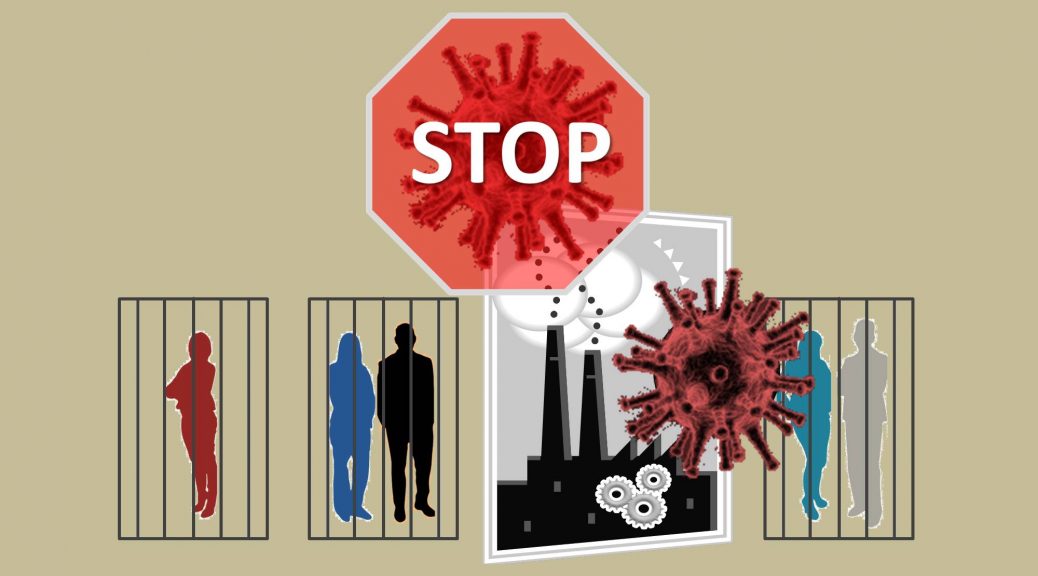

Offenbar unterliegen nicht wenige Politiker ebenfalls dieser Fehleinschätzung, anders lässt sich die fortdauernde Diskussion um neuerliche Einschränkungen und vielleicht sogar einen zweiten wirtschaftlichen Lockdown mit möglicherweise verheerenden Folgen kaum erklären.

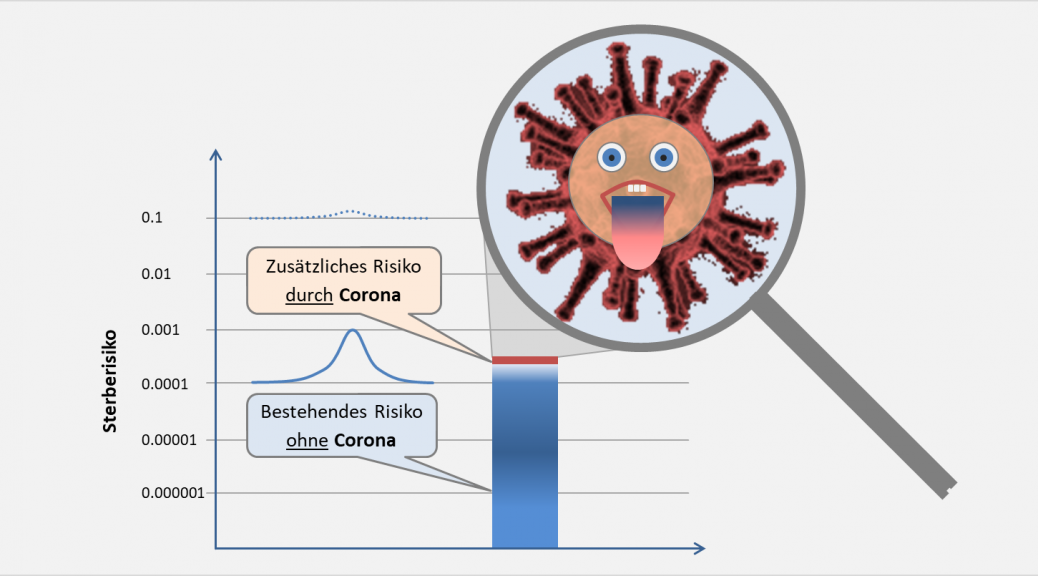

Die rationale Beurteilung des durch Corona entstehenden Risikos kann daher nur in der Bezugnahme auf die allgemeinen oder individuellen Risiken für Krankheit und Tod erfolgen. Im Folgenden wollen wir dafür insbesondere das altersspezifische Sterberisiko als Vergleichsmaßstab wählen. Die Frage ist also, wird das ohnehin für jedermann und jederzeit bestehende Sterberisiko durch die Corona-Gefahren signifikant erhöht? Und wenn, in welchem Maße und mit welchem Effekt? Oder ist dieser Einfluss fallweise vielleicht sogar vernachlässigbar?

Grundlegender Ansatz zur Risikoeinschätzung

Wir betrachten dazu Personen unterschiedlichen Alters und gegebener Kontakthäufigkeit und vergleichen die neu entstehenden Sterberisiken durch die Corona-Gefahren sowohl untereinander wie auch mit den bestehenden Grundrisiken.

Die relevanten Zahlen kommen vom RKI mit dem Stand 17.08.2020:

COVID-19-Fälle insgesamt = 224014

COVID-19-Todesfälle insgesamt= 9232

COVID-19-Genesene insgesamt = 202100

Daraus leiten wir die Anzahl der aktuell Infektiösen (COVID-19-Infektiöse) zu 12682 ab. Nur wer akut infektiös ist, kann andere Personen anstecken. Es sind zunächst also diese knapp 13000 Personen, von denen eine Gefahr für die weitere Verbreitung von COVID-19 ausgeht.

In diesem Zusammenhang drängt sich die berechtigte Frage auf, was ist, wenn es tatsächlich doch viel mehr Infizierte gibt? Das ist das Problem der Dunkelziffer. Da nicht alle über 80 Mio. Menschen in Deutschland kurzfristig getestet werden können, besteht immer die Gefahr, dass viele Positiv-Fälle unentdeckt bleiben. Es könnte also 20000, 40000 oder noch viel mehr akut Infektiöse geben, ohne dass dies in den Zahlen des RKI ausgewiesen wird. Entsprechend wäre selbstredend auch das Infektionsrisiko möglicherweise um mehrere 100% größer. Die vom RKI diesbezüglich dokumentierten Zahlen würden damit die Realität nur unvollständig, vielleicht sogar unfreiwillig geschönt wiedergeben.

Das Problem der unerkannt Infizierten: Die Dunkelziffer

Was für einen Sinn macht denn bei dieser Ausgangslage überhaupt die Bestimmung des Infektionsrisikos oder des Sterberisikos? Ist das nicht ein Stochern im Nebel? Erfreulicherweise nicht. Im Anhang wird gezeigt, dass zumindest die tatsächlichen COVID-19-Erkrankungs- und Sterberisiken in erster Näherung weitgehend unabhängig von der unzweifelhaft bestehenden Unsicherheit bezüglich der Anzahl der Infizierten sind. Dies gilt jedenfalls dann, wenn wir unterstellen, dass sowohl die validen COVID-19-Erkrankungsfälle als insbesondere auch die Anzahl der vom RKI genannten COVID-19 Sterbefälle als vertrauenswürdig angesehen werden können (s. Tabelle 2).

In der Kurzform kann man sich die Begründung folgendermaßen plausibel machen: Nehmen wir an, wir hätten ad hoc einen hochsicheren Corona-Schnelltest zur Verfügung und könnten binnen eines Tages alle 83 Mio. Menschen in Deutschland testen, mit dem Ergebnis, dass 2,5 Millionen Menschen positiv getestet würden. Was änderte sich dadurch? – Die Anzahl der Infizierten verzehnfachte sich. Das wäre bereits alles! Sowohl die Anzahl der COVID-19-Erkrankungen (die Hospitalisierten) als auch die COVID-19-Todesfälle blieben gleich. Wir hätten zwar die 10-fache Anzahl an Infizierten, effektiv aber auch nur ein Zehntel des Risikos für einen ernsten Verlauf oder Todesfolge. Im Ergebnis bliebe sich das gleich, ja man könnte sogar konstatieren, dass das effektive Risiko offenbar viel kleiner ist als gedacht.

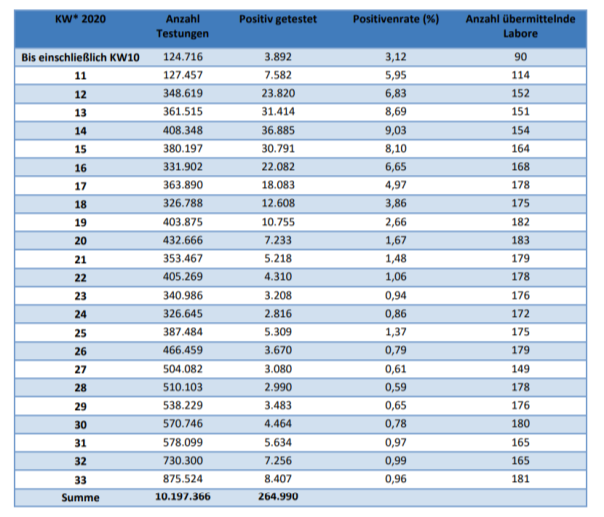

Nur als Randbemerkung: Gegenwärtig durchspielen wir im Grundsatz genau dieses Szenario. Die absoluten Infektionszahlen steigen, gleichzeitig gehen der Hospitalisierungsgrad und das Sterberisiko zurück (s. Tabelle 2).

Tabelle 2: COVID-19 Fallanalysen (Stand 2020-08-18). Quelle: RKI

Der Anteil der positiv Getesteten liegt derzeit unter 1% mit weiter sinkender Tendenz. Die Zahl der COVID-19-Todesfälle stagniert. Die effektive Todesrate sinkt seit dem Höhepunkt im April mit 7% auf jetzt weniger als 1%, teilweise gar 0,5%.

Kommen wir nun zu der angekündigten Analyse bezüglich der effektiven Erkrankungs- und Sterberisiken aufgrund von Corona.

Vorgehen zur Ableitung einer sinnvollen Risikobeurteilung

Was ist überhaupt ein Risiko? Es kann quantifiziert werden als die Wahrscheinlichkeit für das Eintreten eines definierten ungünstigen Ereignisses. Das maximal ungünstigste Ereignis ist fraglos der Tod. Durch das Sterberisiko wird die Wahrscheinlichkeit quantifiziert, in einem bestimmten Zeitabschnitt abzuleben. Für das allgemeine Sterberisiko gibt es valide Zahlen für alle Altersgruppen. Im Hinblick auf COVID-19 werden je nach Quelle unterschiedliche Angaben zum Sterberisiko gemacht, die zum Teil um mehr als 50% voneinander abweichen. Indessen kommt es bei unserer Betrachtung nicht darauf an, das durch Corona erhöhte altersgruppenspezifische Sterberisiko exakt zu bestimmen (das müssen medizinische Studien leisten), das Ziel ist vielmehr, den Vergleich mit dem bestehenden Grundrisiko vorzunehmen. Wir werden sehen, dass in Abhängigkeit von der Kontakthäufigkeit in fast allen Altersgruppen das von Corona ausgehende Sterberisiko deutlich kleiner ist, als das allgemeine Sterberisiko, teilweise sogar erheblich kleiner (bis zu einem Faktor 100).

Es macht Sinn, drei Aspekte separat zu analysieren und zueinander in Bezug zu setzen.

A. Das allgemeine Sterberisiko einer Altersgruppe bei Abwesenheit von Corona.

B. Das spezifische Sterberisiko einer Altersgruppe bei bestehendem Infektionsrisiko (aber noch nicht erfolgter Infektion).

C. Das spezifische Sterberisiko einer Altersgruppe bei einer vorliegenden COVID-19-Infektion.

Durch A wird die Risikoreferenz gesetzt: Weniger Sterberisiko geht im statistischen Mittel nicht. Fraglos wird durch Corona das Sterberisiko grundsätzlich erhöht. Es ist interessant, zu sehen, wie hoch der Effekt einer COVID-19-Erkrankung (also das Sterberisiko nach C) im Vergleich zu den Grundrisiken hier tatsächlich ist. Unter B betrachten wir das resultierende Sterberisiko als Verkettung der Teilrisiken

B1: Kontakt mit akut ansteckenden Infizierten – B2: Infektion – B3: Ernsthafte Erkrankung (Hospitalisierung) – B4: Todesfolge

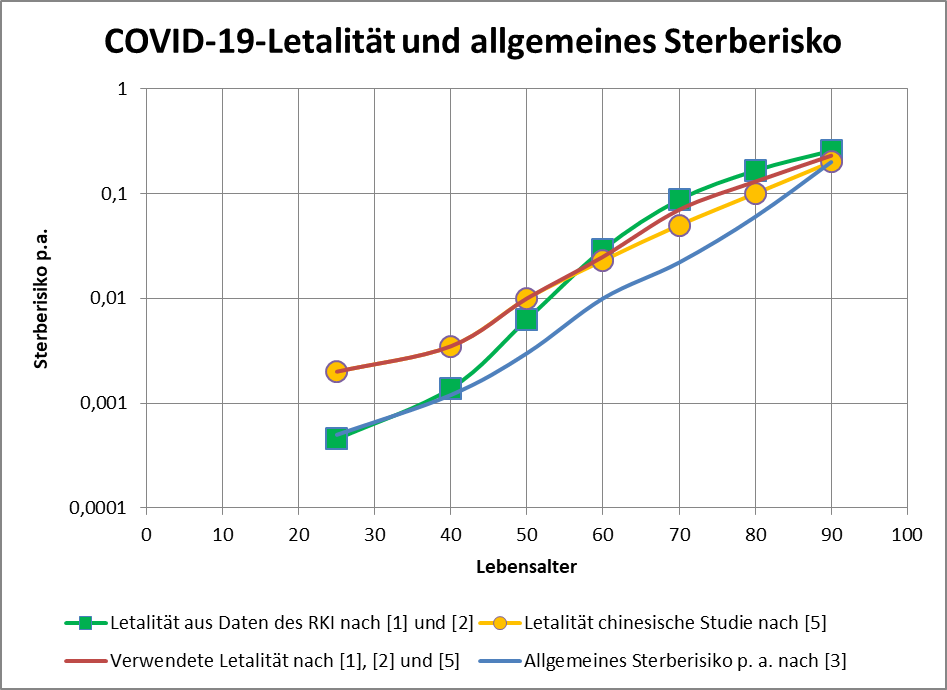

COVID-19-Letalität und allgemeines Sterberisiko

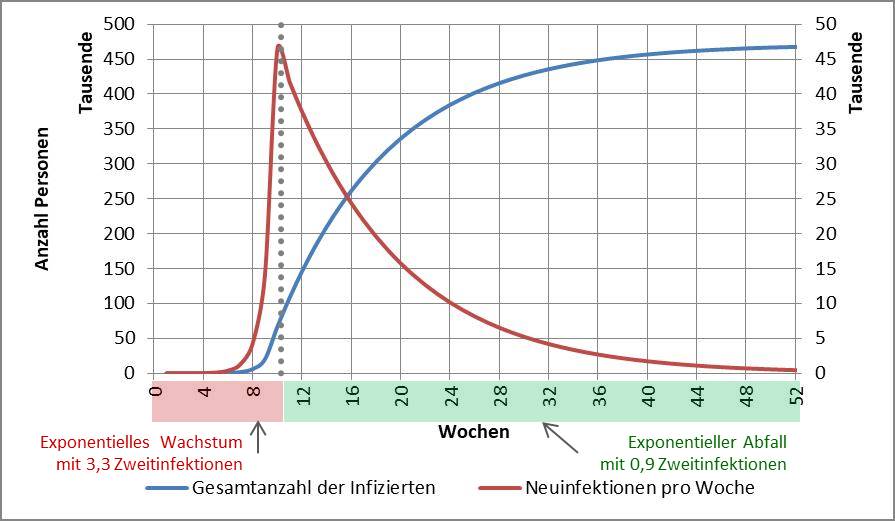

Die Teilrisiken B3 und B4 ergeben zusammen das Sterberisiko bei einer vorliegenden COVID-19-Infektion, also die Letalität. In [5] sind diese Werte aus einer chinesischen Studie über mehr als 44.000 Infizierten direkt dokumentiert. Aus den Daten des RKI nach [1] und [2] lässt sich gleichfalls eine Letalität ableiten, die sich indes moderat von den Zahlenwerten nach [1] unterscheidet. In Abb. 1 (COVID-19-Letalität und allgemeines Sterberisiko) sind die erhaltenen altersgruppenspezifischen Letalitätswerte aufgetragen. Für mittlere und hohe Lebensalter ergeben sich vernachlässigbare Unterschiede zwischen den beiden Letalitätskurven. Bei den jüngeren Infizierten (25 Jahre) liegt die aus den Daten des RKI erhaltene Letalität nur bei 0,00045 (orangefarbene Kurve) im Vergleich zu 0,002 (rote Kurve). Das klingt nach einem großen Unterschied, indessen steht aber auch der höhere Letalitätswert für ein letzten Endes sehr geringes COVID-10-Sterberisiko von 1:500 bzw. 0,2% (bei dieser Altersgruppe).

Im Folgenden beziehen wir uns für Jüngere auf die pessimistischeren Werte nach [5] (gelbe Kurve mit gelben Kreisen) und passen die Letalitätswerte für Ältere in Richtung der ungünstigeren Werte des RKI an (grüne Kurve mit grünen Quadraten). Im Ergebnis erhalten wir den roten Graphen in Abb. 1. Angemerkt sei, dass durch die aktuellen Zahlen des RKI (s. Tab. 2) eine weiterhin stark zurückgehende Letalität dokumentiert wird. Im Sinne einer Negativabgrenzung bleiben wir dennoch bei den höheren Werten. Damit können wir sicherstellen, dass das tatsächlich bestehende Risiko eher noch kleiner ist als das in der nachfolgenden Risikobetrachtung abgeleitete.

Abbildung 1: COVID-19-Letalität und allgemeines Sterberisiko. Dargestellt sind die altersgruppenspezifischen COVID-10-Sterberisiken bei nachgewiesener Infektion mit dem Corona-Virus, einmal abgeleitet aus den Daten des RKI ([1] und [2]), zum anderen übernommen aus einer chinesischen Studie [5]. Die rote Kurve steht für die im Text herangezogene COVID-19-Letalität. Das allgemeine Sterberisiko (ohne Corona) ist zum Vergleich aufgetragen. Man beachte die logarithmische Skalierung.

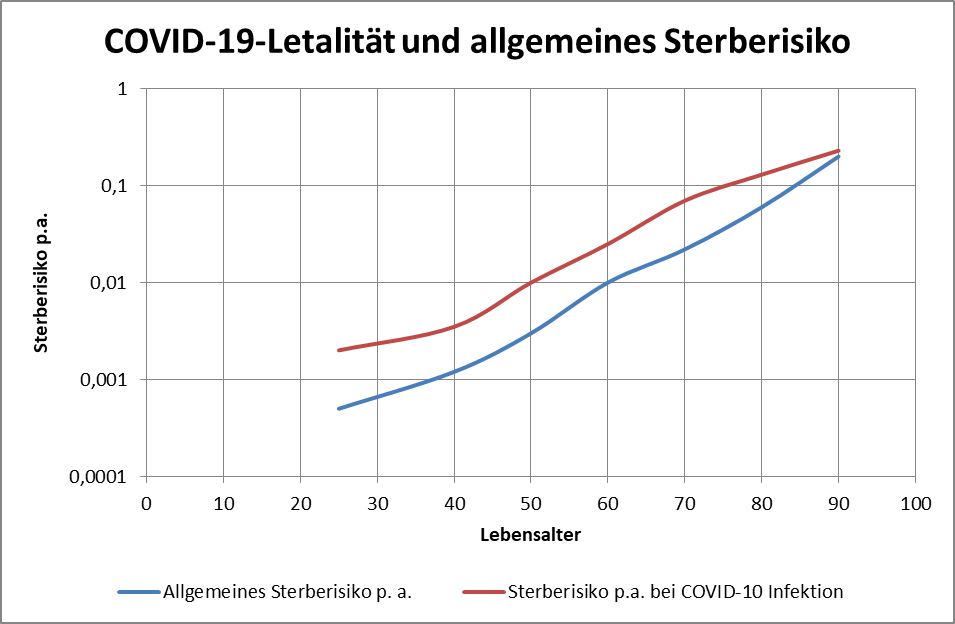

Der besseren Übersichtlichkeit halber sind in Abb. 2 die beiden relevanten Kurven nochmals dargestellt.

Abbildung 2: COVID-19-Letalität und allgemeines Sterberisiko. Dargestellt sind das allgemeine Sterberisiko (ohne Corona) und das Sterberisiko bei einer bereits vorliegenden COVID-19-Infektion (Letalität). Man beachte die logarithmische Skalierung.

Vergleicht man nun die rote Kurve mit der blauen der grundsätzlich bestehenden allgemeinen Sterberisiken, so erkennt man, dass, wie nicht anders zu erwarten, das Sterberisiko durch eine vorliegende COVID-10-Infektion erhöht wird. Die Erhöhung ist nicht dramatisch, aber signifikant. Doch ist dieser direkte Vergleich überhaupt aussagefähig? Es wird hier ja unterstellt, man sei bereits mit dem Corona-Virus infiziert, was ja derzeit tatsächlich nur für etwa 0,3% der Bevölkerung zutrifft, akut sogar nur für ca. 0,015%. Für 99,7% besteht das Risiko in der Form nicht bzw. nur sehr indirekt über die Gefahr einer möglichen aber dennoch relativ unwahrscheinlichen Infektion.

Formale Risikobestimmung

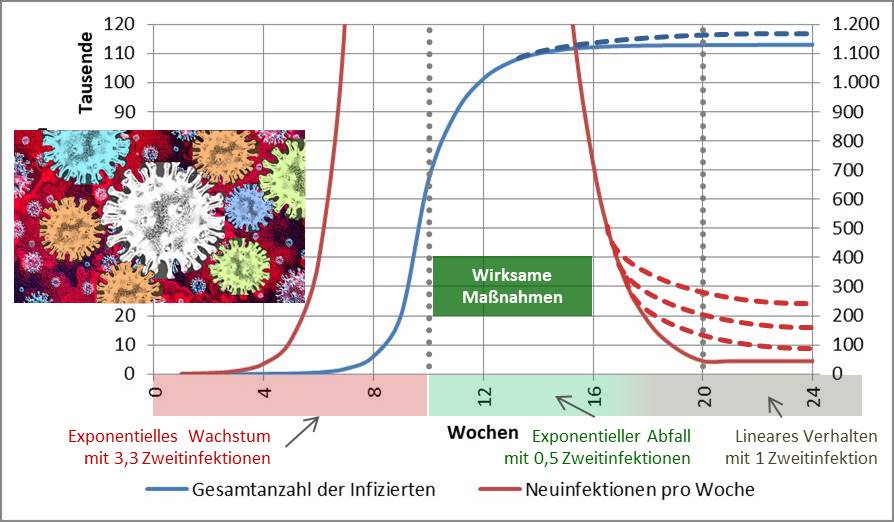

Sehr viel sinnvoller ist die Betrachtung der gesamten Risikokette nach B1-B2-B3-B4, wie oben skizziert. Das Risiko B1 für den Kontakt mit einer akut ansteckenden Person hängt unmittelbar ab von der Kontakthäufigkeit. Wir variieren hierzu die Anzahl der Kontaktpersonen von 5 Personen pro Tag über 10, 20 und 50 Personen pro Tag und betrachten ein differenziertes Kontaktprofil mit 20, 10, 10, 10, 5, 3 bzw. 2 Kontakten pro Tag bei den unterschiedlichen Lebensaltern 25, 40, 50, 60, 70, 80 bzw. 90. Aus den Kontakthäufigkeiten können wir nun leicht die statistischen Wahrscheinlichkeiten für die Begegnung mit einer infektiösen Person errechnen und in der Folge die Infektionswahrscheinlichkeit B2 sowie das daraus abgeleitete Erkrankungsrisiko B3 (Hospitalisierung) und letztlich das Sterberisiko B4 bestimmen. Da wir insbesondere an Letzterem interessiert sind, berechnen wir das Sterberisiko mittels der Letalität direkt aus B2.

Der formelmäßige Zusammenhang ist wie folgt:

Sterberisiko B4 = Anzahl Kontakte pro Tag * Infektionsrisiko * Letalität

Nicht jeder Kontakt führt zu einer Infektion. Eine Ansteckung im Vorbeigehen ist sehr unwahrscheinlich. Wenn wir hier von Kontakten sprechen, dann meinen wir schon ein Minimum an Innehalten und beieinanderstehen. Zur Erinnerung: auch die Corona Warn-App dokumentiert nur Kontakte mit einer Verweildauer von mindestens 15 Minuten in weniger als 2 m Abstand. Das tatsächliche Ansteckungsrisiko bei einer normal-distanzierten Begegnung mit Fremden oder Bekannten pro individuellen Kontakt ohne Maske kann auf etwa p_K = 10% abgeschätzt werden, bei einem längeren oder sorgloserem Kontakt vielleicht p_K = 20%. Das Infektionsrisiko bestimmt sich daher zu

Infektionsrisiko = p_K * COVID-19-Infektiöse / Einwohnerzahl

Damit können wir nun die Sterberisiken für die unterschiedlichen Kontaktprofile leicht bestimmen.

Risikoanalyse in Abhängigkeit von der Kontakthäufigkeit

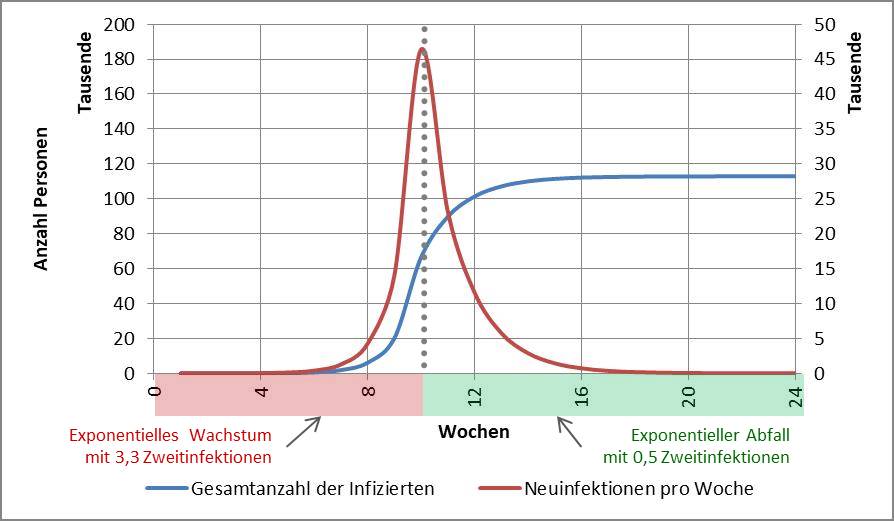

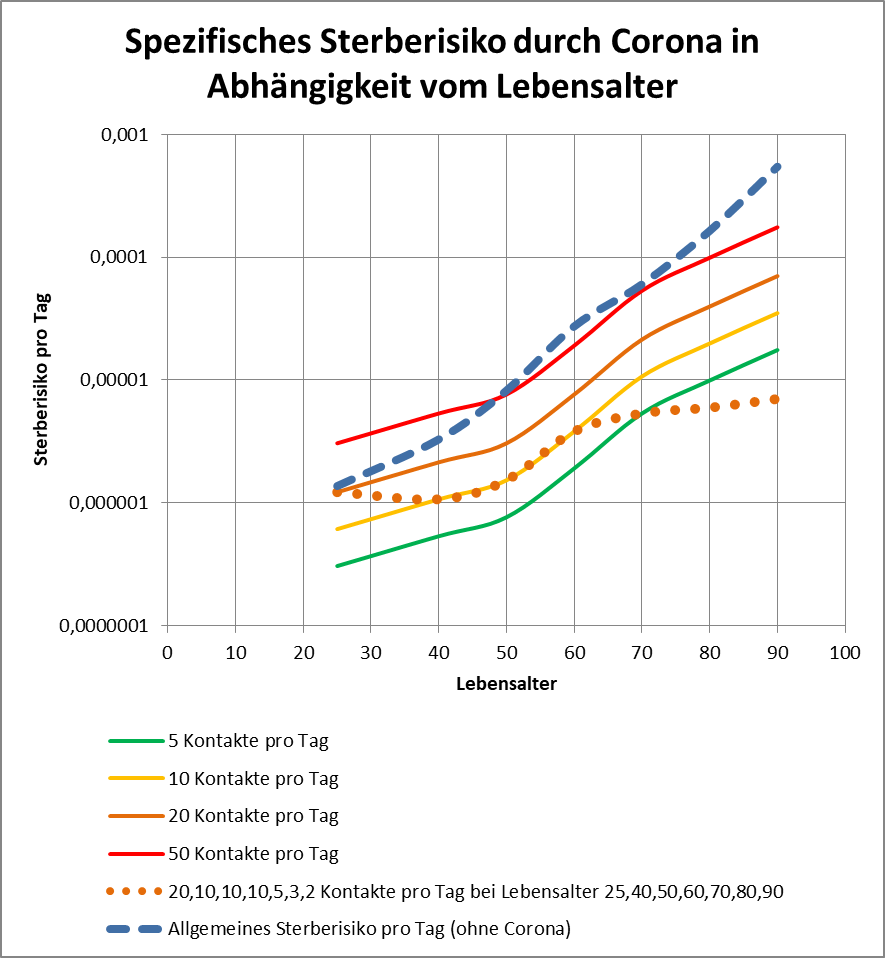

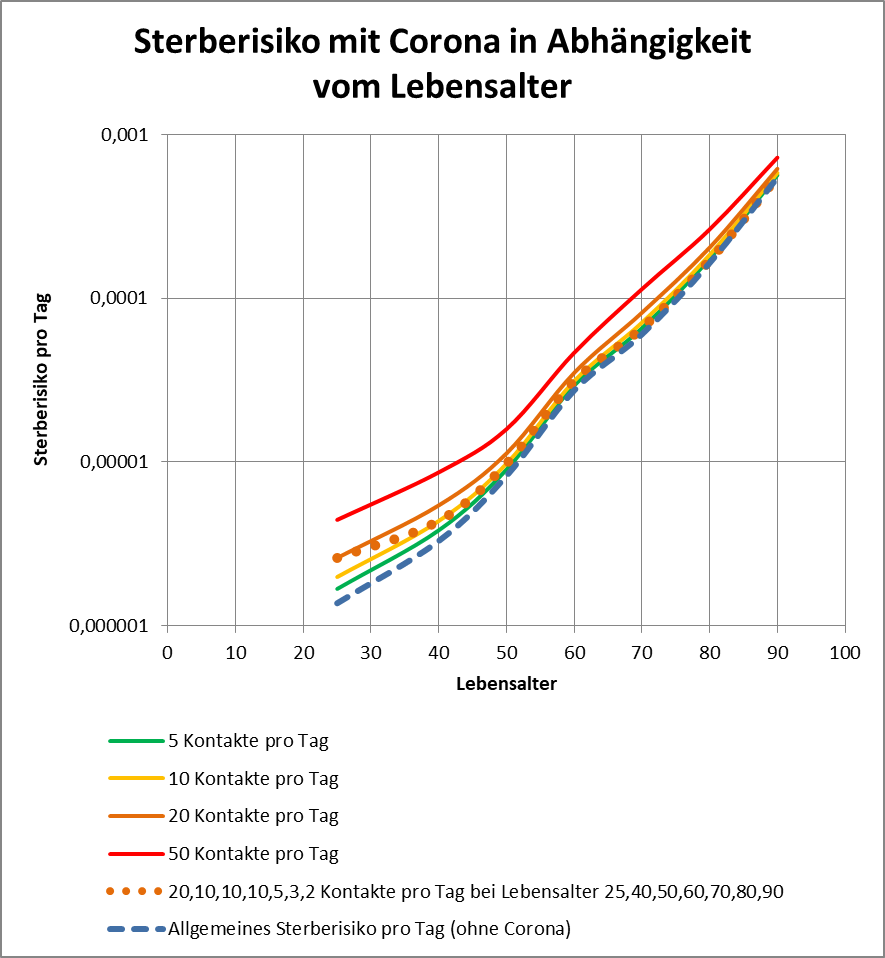

Für die genannten unterschiedlichen Kontaktprofile ist in Abb. 3 das resultierende spezifische Sterberisiko durch Corona dargestellt. Man erkennt, dass bei weniger als 20 Kontakten pro Tag, das durch Corona zusätzlich entstehende Sterberisiko über alle betrachteten Altersgruppen hinweg kleiner ist als das allgemeine Grundrisiko bei Abwesenheit von Corona. Sogar bei 50 Kontakten pro Tag bleibt das Risiko für die Mehrheit der Altersgruppen unter dem allgemeinen Sterberisiko. Bei 5 Kontakten pro Tag liegt das Corona-Sterberisiko teilweise um eine Zehnerpotenz unter dem bestehenden allgemeinen Sterberisiko. Im Falle des als realitätsnah angesehenen Kontaktprofils (gepunktete orangefarbene Kurve) bleiben wir insbesondere für die Älteren teilweise um mehr als den Faktor 10 unter dem altersspezifischen Grundrisiko. Bei den 25-Jährigen liegen wir auf dem Niveau des allgemeinen Sterberisikos, dies ist indes von geringerer Bedeutung, da diese Altersgruppe ein sehr niedriges Grundrisiko aufweist. Dazu weiter unten mehr.

Anzumerken bleibt, dass wir bei den Gruppen der 25- und 40-Jährigen das Ansteckungsrisiko pro Kontakt auf p_K = 20% taxiert haben, bei allen anderen auf p_K = 10%. Für die von der Anzahl der Kontakte abhängige Bestimmung des Infektionsrisikos haben wir ferner die o.g. Eckdaten des RKI zugrunde gelegt, also aktuell 12682 COVID-19-Infektiöse bei 83. Mio. Einwohnern. Das entspricht einem pauschalen Infektionsrisiko von etwa 0,015% (= 1:6500) pro Kontakt mit sicherer Virusübertragung, bzw. 0,0015% (= 1:65000) pro Kontakt mit 10%-iger Übertragungswahrscheinlichkeit.

Abbildung 3: Spezifisches Sterberisiko durch Corona in Abhängigkeit vom Lebensalter. Man beachte die logarithmische Skalierung. Aufgetragen ist das spezifisch auf Corona zurückzuführende Sterberisiko bei unterschiedlichen Kontaktprofilen.

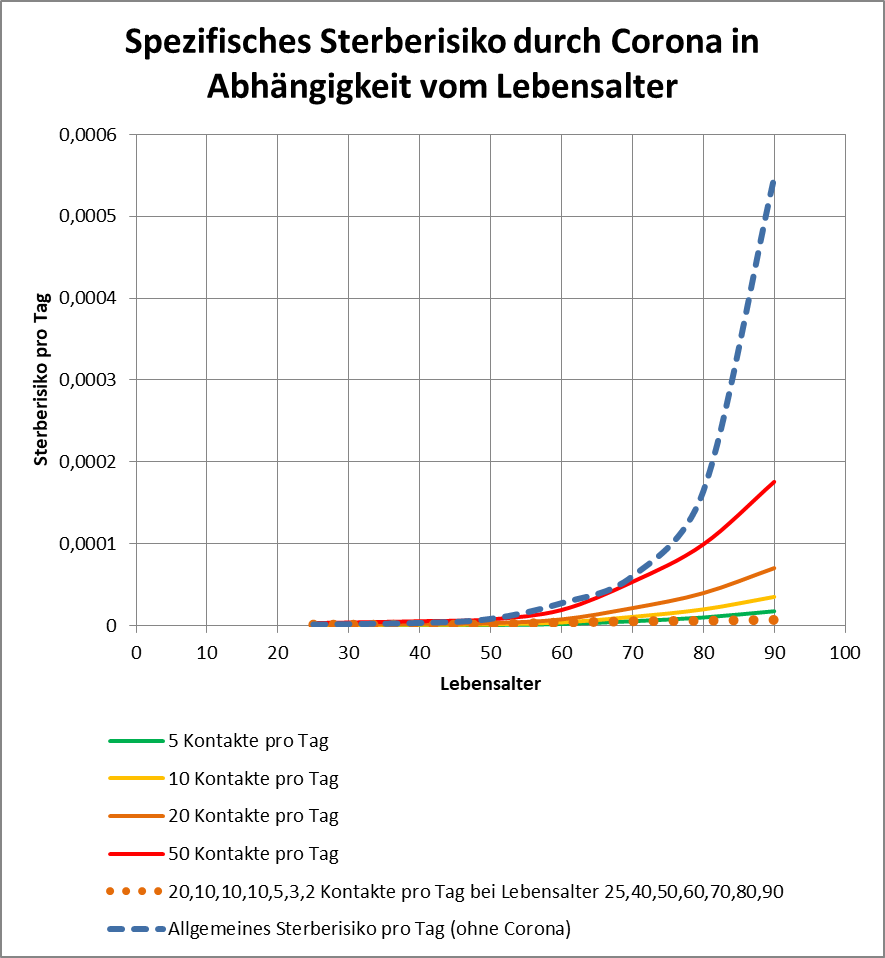

In Abb. 4 sind dieselben Risikoverläufe dargestellt, nun aber mit linearer statt logarithmischer Skalierung. Bis zum Alter von 50 liegen die Kurven alle so nah an der Nulllinie, dass die Unterschiede kaum erkennbar sind. Bei den Altersgruppen 70, 80 und 90 erkennt man aber unmittelbar, wie klein das durch Corona induzierte zusätzliche Sterberisiko im Vergleich zum altersbedingt bestehenden hohen Sterberisiko ohne Corona ist.

Abbildung 4: Spezifisches Sterberisiko durch Corona in Abhängigkeit vom Lebensalter. Aufgetragen ist das spezifisch auf Corona zurückzuführende Sterberisiko bei unterschiedlichen Kontaktprofilen. Im Unterschied zu Abb. 3 hier in linearer Skalierung.

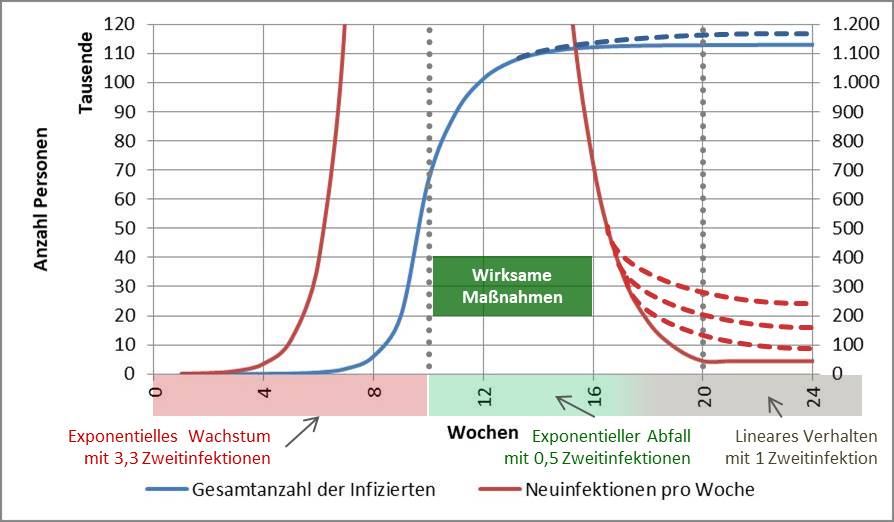

Effektives Sterberisiko in der „Corona-Pandemie“

Wir haben hier nur das spezifisch durch Corona hinzu gekommene Risiko betrachtet. Natürlich will man auch wissen, wie sich das kumulierte Sterberisiko nun darstellt: Grundrisiko ohne Corona + zusätzliches Sterberisiko durch Corona. Die betreffenden Kurven für die unterschiedlichen Kontaktprofile sind in Abb. 5 dargestellt. Als Referenz ist die Kurve für die Sterbewahrscheinlichkeit ohne Corona ebenfalls mit aufgeführt (gestrichelte blaue Kurve). Wie kaum anders zu erwarten, führt das zusätzliche Risiko durch Corona im Wesentlichen zu einer Vertikalverschiebung der Sterberisikoverläufe nach Lebensalter, eine etwas größere Verschiebung bei der jüngeren Altersgruppe, eine etwas kleinere Verschiebung bei den höheren Lebensaltern.

Abbildung 5: Sterberisiko mit Corona in Abhängigkeit vom Lebensalter. Aufgetragen ist das resultierende Gesamt-Sterberisiko (Grundrisiko plus Zusatzeinfluss durch Corona) bei unterschiedlichen Kontaktprofilen. Man beachte die logarithmische Skalierung.

Man muss hier gar nicht ins Detail gehen, um zu erkennen, dass die resultierenden Sterberisiken unter Einbeziehung der Corona-Gefahr bei maximal 20 Kontakten pro Tag (grüne, gelbe, orangefarbene Kurven und die punktierte Linie) sich nur geringfügig vom bestehenden allgemeinen Sterberisiko abheben. Sogar bei 50 Kontakten pro Tag liegt die resultierende Kurve fast deckungsgleich auf dem Niveau der allgemeinen altersspezifischen Sterbewahrscheinlichkeiten, wie sie in [3] für Männer mit der Jahresreferenz 1986/88 ausgewiesen wird. Etwas flapsig könnte man also sagen, 50 sorglose Kontakte pro Tag sind im Hinblick auf das kumulierte Sterberisiko wie eine Zeitreise zurück in die 1980er Jahre. Das ist weitab von einem Katastrophenszenario.

Bei einem Minimum an vernünftigen Verhalten dürften für die meisten Menschen die Kontaktprofile mit 20 und weniger effektiv zu zählenden Kontakten machbar sein. Damit liegen wir beim resultierenden Sterberisiko durch Corona so nahe an der altersspezifischen Basissterbewahrscheinlichkeit (blaue Kurve), dass man schon in den Bereich der statistischen Unschärfe gerät. Linear interpoliert entspräche etwa die orangefarbene Kurve mit 20 Kontakten pro Tag der allgemeinen Sterbewahrscheinlichkeit für Männer (ohne Corona) um das Jahr 2000 (s. [3]).

Sterberisiko ohne und mit Corona im Vergleich

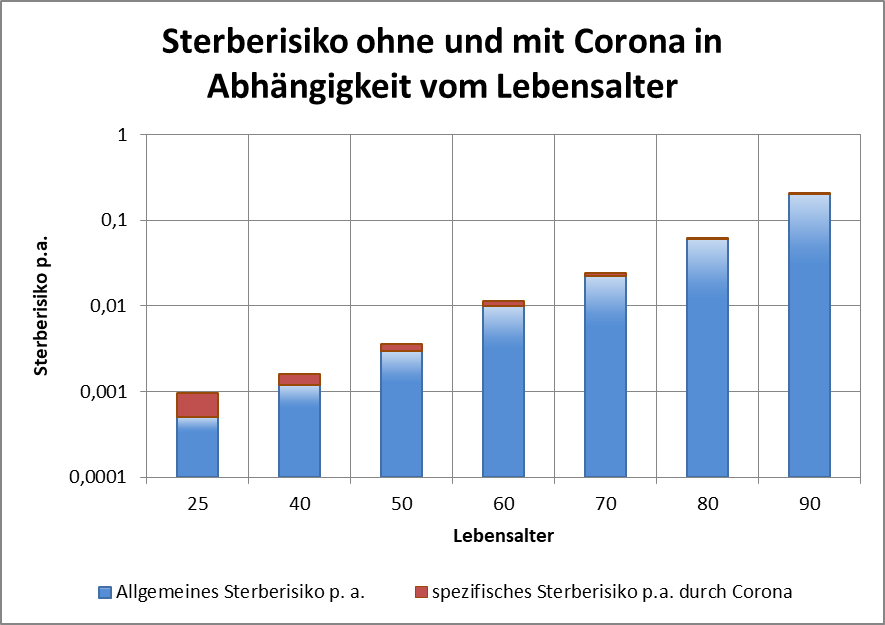

Im nachfolgenden Balkendiagramm (s. Abb. 6) sind die Sterbewahrscheinlichkeiten ohne und mit Corona nochmals sehr prägnant dargestellt.

Abbildung 6: Sterberisiko ohne und mit Corona in Abhängigkeit vom Lebensalter. Dargestellt sind das Grundrisiko ohne Corona (blau) und das Zusatzrisiko durch Corona (rot). Zugrunde gelegt ist das differenzierte Kontaktprofil mit 20, 10, 10, 10, 5, 3 bzw. 2 Kontakten pro Tag bei den unterschiedlichen Lebensaltern 25, 40, 50, 60, 70, 80 bzw. 90. Die Säulenhöhe markiert das resultierende Gesamtrisiko. Man beachte die logarithmische Skalierung.

Die blauen Balken zeigen das allgemeine Sterberisiko ohne Corona, die roten Balken darüber offenbaren den zusätzlichen Einfluss durch die Corona Gefahr. Die Bezugsgröße ist hier das differenzierte Kontaktprofil mit 20, 10, 10, 10, 5, 3 bzw. 2 Kontakten pro Tag bei den unterschiedlichen Lebensaltern 25, 40, 50, 60, 70, 80 bzw. 90. Die Grafik spricht für sich!

Es fällt auf, dass die Corona-bedingten Zusatzrisiken bei den Jüngeren höher ausfallen als bei den Älteren. Ein deutlich gesteigertes zusätzliches Risiko bei der ersteren Altersgruppe, im Gegensatz dazu ein kaum sichtbares Corona-Zusatzrisiko bei den ganz Alten. Das scheint der beobachteten auffallend hohen COVID-19-Letalität bei Menschen über 60 zu widersprechen.

Wird das Sterberisiko durch Corona nennenswert erhöht?

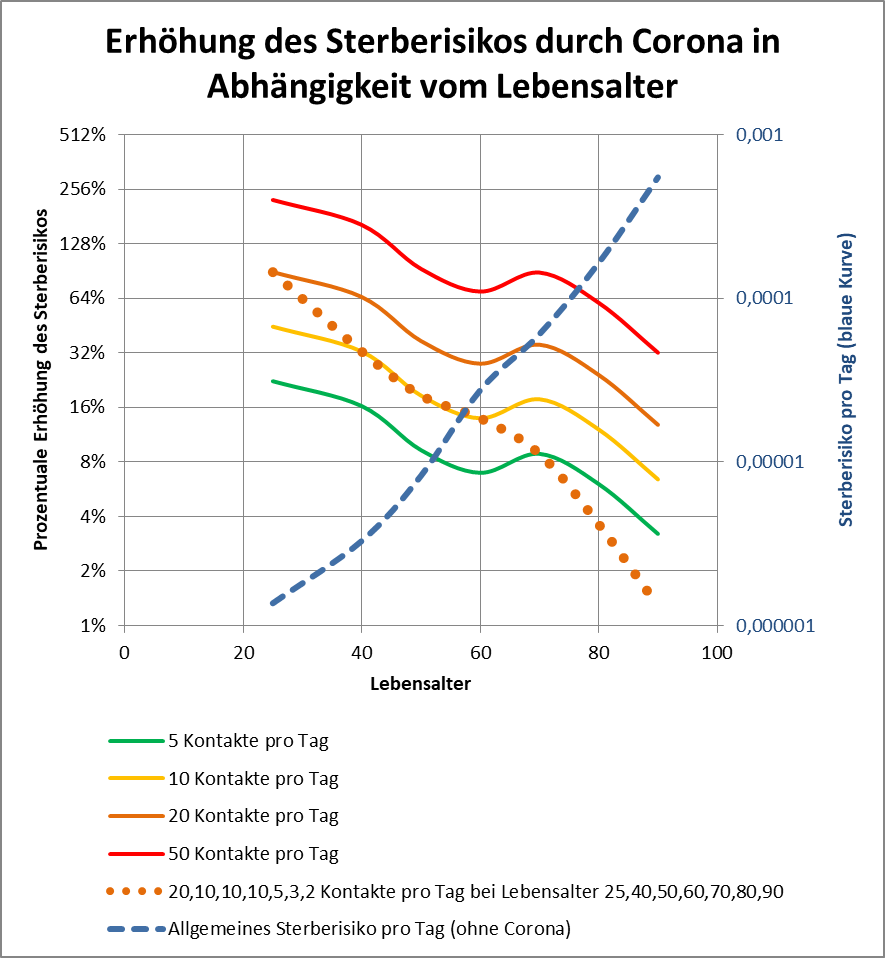

Auf den ersten Blick vermeintlich noch unklarer wird die Situation, wenn wir direkt die altersgruppenspezifischen Erhöhungen im Sterberisiko miteinander vergleichen.

Wir werfen dazu einen Blick auf Abb. 7. Auf der linken Achse ist die prozentuale Erhöhung des Sterberisikos durch Corona aufgetragen. Sie gilt für die farbigen Kurven mit 5 bis 50 Kontakten pro Tag und das differenzierte Kontaktprofil mit 20, 10, 10, 10, 5, 3 bzw. 2 Kontakten pro Tag bei den unterschiedlichen Lebensaltern 25, 40, 50, 60, 70, 80 bzw. 90 (punktiert). Auf der rechten Achse kann man das Sterberisiko ohne Corona ablesen (blau gestrichelte Linie).

Ein Beispiel: Für die Altersgruppe 40 Jahre weist die grüne Kurve auf der linken Achse einen Wert von 16% auf. Demnach erhöht sich für 40-Jährige das allgemeine Sterberisiko mit durchschnittlich 5 Kontakten pro Tag durch Corona um 16% (also um den Faktor 1,16). Für 80-Jährige erhöht sich das Risiko indessen nur um etwa 6% (also um den Faktor 1,06), für 90-Jährige mit 2 Kontakten pro Tag gar nur um etwa 1% (orangefarbene, punktierte Linie) – das ist kaum messbar. Nochmals extremer wird der Unterschied, wenn man die Erhöhung des Sterberisikos durch Corona bei 25-Jährigen im differenzierten Kontaktprofil mit den Werten bei den 90-Jährigen vergleicht: Es sind 91% mehr im ersten Fall, aber nur 1,3% bei den ganz Alten. Wie kann es angesichts dessen zu der vielfach höheren Anzahl an COVID-19-Sterbefällen bei den Alten im Vergleich zu den Jüngeren kommen?

Bevor wir diese Frage beantworten, wollen wir die Prozentangaben im Hinblick auf das Sterberisiko kurz einordnen. Es ist mittlerweile Allgemeinwissen, dass Bewegung der Gesundheit zuträglich ist, das ist durch zahlreiche Studien belegt. Teilweise werden bereits für moderat intensive Alltagsbewegung eine Reduzierung des Sterberisikos von 19 % und bei höher intensivem Ausdauertraining und Sport von 39 % genannt (s. [12]). Schon damit wird klar: Die abgeleiteten höheren Sterberisiken durch Corona bewegen sich im Bereich von Individualentscheidungen der eigenen Lebensführung. Ähnliches kann man natürlich auch von gesunder Ernährung und dem Verzicht auf potentiell krankmachende Genussmittel (Tabak, Alkohol, Zucker) oder eben deren bewusstem Genuss sagen.

Abbildung 7: Erhöhung des Sterberisikos durch Corona in Abhängigkeit vom Lebensalter. Die farbigen Kurven mit 5 bis 50 Kontakten pro Tag und das differenzierte Kontaktprofil mit 20, 10, 10, 10, 5, 3 bzw. 2 Kontakten pro Tag bei den unterschiedlichen Lebensaltern 25, 40, 50, 60, 70, 80 bzw. 90 (punktiert) zeigen auf der linken Achse die prozentuale Erhöhung des Sterberisikos im entsprechenden Lebensalter an. Das bestehende Grundrisiko ohne Corona wird mittels der blau-gestrichelten Kurve dargestellt (rechte Achse). Man beachte die logarithmische Skalierung in beiden Achsen.

Größere relative Risikosteigerung durch Corona bei den Jungen als bei den Alten

Es besteht nur scheinbar ein Widerspruch, den wir im Folgenden aufklären.

Wie man Abb. 6 entnehmen kann, hat die Altersgruppe der 25-Jährigen statistisch gesehen auch inklusive des Corona-bedingten zusätzlichen Sterberisikos immer noch eine vielfach höhere Überlebenswahrscheinlichkeit (ca. 65-fach) im Vergleich zur Gruppe der 80-Jährigen (man beachte die logarithmische Skalierung). Verglichen mit den 90-Jährigen ist dieser Wert gar um den Faktor 210 höher. Das bleibt bezüglich der tatsächlichen Sterbezahlen nicht ohne Folge und erklärt die vermeintliche Unstimmigkeit.

In [6] sind u.a. die Todesraten für die Gruppe der 20-29-Jährigen und die Gruppe der 80-89-Jährigen dokumentiert. Den 8 COVID-19-Toten im Alter zwischen 20 und 30 stehen 3704 COVID-19-Sterbefälle im Alter zwischen 80 und 90 gegenüber, das sind 463-mal so viele.

Um die Auflösung des Widerspruchs an einem Beispiel plausibel zu machen: Nehmen wir zwei Trinkbecher. Den ersten machen wir halbvoll mit Wasser, den zweiten füllen wir bis knapp unter den Rand. In beiden Bechern markieren wir den Füllstand. Nun lassen wir aus geringer Höhe einen Kieselstein in den ersten Becher fallen. Was beobachten wir? Das Wasser gerät in Wallung und schwappt hoch, bleibt aber unterhalb des Becherrands. Nur einige weniger Spritzer gehen darüber hinaus. Wir nehmen den Kieselstein heraus und betrachten den Füllstand im ersten Becher: keine merkliche Veränderung.

Kommen wir zum zweiten Becher. Aus der gleichen Höhe wie zuvor lassen wir den Kieselstein in den Becher fallen. Was passiert? Wieder kommt das Wasser in Wallung. Weil aber der Füllstand sehr hoch ist, schwappt nun einiges vom Inhalt über den Rand hinaus. Wenn wir den Stein herausnehmen, sehen wir, dass die Füllmenge im zweiten Becher deutlich sichtbar unterhalb der Füllstandmarkierung liegt.

In beiden Fällen war die äußere Anregung dieselbe, in Relation zum Inhalt war die Einwirkung beim ersten Becher sogar doppelt so stark. Trotzdem konstatieren wir im Ergebnis einen signifikanten Unterschied zu Ungunsten der Situation beim zweiten Becher mit der in Relation nur halb so starken äußeren Einwirkung.

Die wenigen Wasserspritzer aus dem ersten Becher stehen für die sehr niedrigen COVID-19-Todesraten bei den 20-29-Jährigen. Der viel höhere Verlust an Füllmenge im zweiten Becher entspricht der im Vergleich so überaus beträchtlicheren relativen und absoluten COVID-19-Sterblichkeit bei den über 80-Jährigen.

Was man der oben zitierten Sterbegrafik in [6] übrigens auch entnehmen kann: Nur etwa 0,2% aller Todesfälle bei den 20-29-Jährigen und etwa 1% bei den 80-89-Jährigen gehen tatsächlich auf COVID-19 zurück. Nach wie vor sind also die „allgemeinen Sterberisiken“ in einer angesichts der vorherrschenden Pandemie-Stimmung fast surreal anmutenden Weise dominant gegenüber der von COVID-19 ausgehenden Gefahr. Sogar in der Altersgruppe der besonders gefährdeten über 80-Jährigen sterben unglaubliche 99% aufgrund von anderen Todesursachen.

Resümee

Aus den vorliegenden Daten zu den Fallzahlen der mit dem Corona-Virus Infizierten, der Genesenen und den COVID-19-Todesfällen haben wir durch Vergleich mit den altersspezifischen Sterbewahrscheinlichkeiten aus der Vor-Corona-Zeit das vom Virus ausgehende tatsächliche Risiko bestimmt. Es zeigt sich, dass dieses Zusatzrisiko relativ gering ist und sich einordnet in die Höhe der individuellen Lebensrisiken aufgrund persönlicher Entscheidungen zur Lebensführung (z.B. betreffend Gesundheitsvorsorge, Ernährung und Sport).

Tatsächlich sind Herz-Kreislaufversagen mit 36% aller Fälle und Krebs mit 25% die häufigsten Todesursachen, mehr als eine halbe Million sterben jedes Jahr daran. Sogar Stürze (16.201 in 2018) liegen mit einem Anteil von 1,7% aller Todesursachen noch klar über der Anzahl der COVID-19-Todesfälle. Hat man deswegen schon erwägt, Haushaltsleitern zu verbieten? Die Anzahl der Suizide ist in etwa auf dem Niveau der durch Corona bedingten Todesfälle.

Fakt ist: Nur etwa 0,2% aller Todesfälle bei den 20-29-Jährigen und etwa 1% bei den 80-89-Jährigen gehen tatsächlich auf COVID-19 zurück. Das steht im Einklang mit dem abgeschätzten COVID-19-Sterberisiko als Endprodukt der Kette „Kontakt mit akut ansteckenden Infizierten“ – „Infektion“ – „Ernsthafte Erkrankung (Hospitalisierung)“ – „Tod“. Unter Zugrundelegung eines differenzierten Kontaktprofil mit 20, 10, 10, 10, 5, 3 bzw. 2 Kontakten pro Tag bei den unterschiedlichen Lebensaltern 25, 40, 50, 60, 70, 80 bzw. 90 hatten wir für die Gruppe der Jüngeren (25 Jahre) ein Zusatzrisiko von 20 % erhalten, was hier allerdings nicht durchschlägt, weil das Sterberisiko von 25-Jährigen per se vernachlässigbar ist (s. o.). Bei den sehr Alten (über 80) liegt das Zusatzrisiko nur bei 1 – 4 %. Das tagesbezogene Sterberisiko vergrößert sich hier für die 80-Jährigen von 1:6083 auf 1:5871 und für die 90-Jährigen von 1:1825 auf 1:1802 – das sind kaum wirklich nennenswerte Unterschiede.

Der Anteil der positiv Getesteten liegt derzeit unter 1% mit weiter sinkender Tendenz. Die Zahl der COVID-19-Todesfälle stagniert. Die effektive Todesrate ist seit dem Höhepunkt im April mit 7% auf weniger als 1% gefallen, und sie sinkt weiter, teilweise auf 0,5%.

Es erscheint völlig klar, dass diese Zahlen eine weitere Beeinträchtigung des öffentlichen Lebens und der Wirtschaft in der bisherigen Form in keiner Weise rechtfertigen. Man muss vielmehr genau hinschauen, welche Verbote überhaupt noch ihren Sinn erfüllen. Das gilt sicher für Massenveranstaltungen mit wahllosen und engen Kontakten. Nahezu alles andere muss aber auf den Prüfstand. Das heißt nicht, die Corona-Gefahr zu leugnen, es heißt vielmehr, der tatsächlichen bestehenden Gefahr mit Vernunft und Augenmaß zu begegnen. Gutmeinend erlassene Verbote helfen da nicht weiter, schon gar nicht Denkverbote.

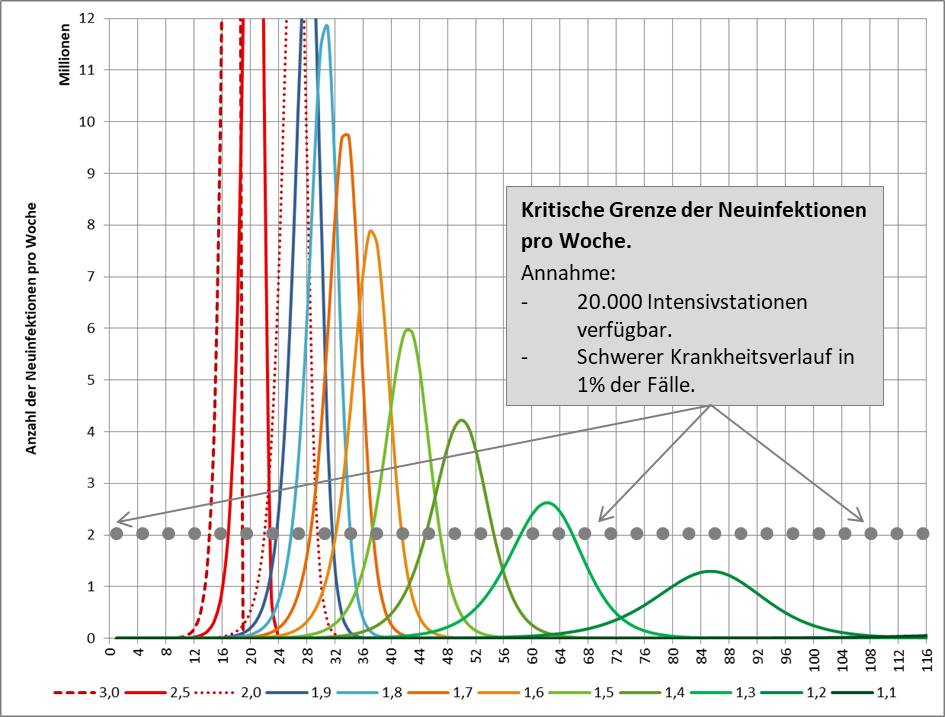

Das Gerede von der Corona-Pandemie „als der größten Herausforderung seit dem zweiten Weltkrieg“ ist grob fahrlässig und hat im Ergebnis einen beträchtlichen Schaden in nahezu allen Lebensbereichen angerichtet. Diese Aussage ist ein politischer Kakophemismus, der durch die Fakten nicht ansatzweise gedeckt wird. Sogar auf dem Höhepunkt der sogenannten ersten Welle waren die Intensivbettkapazitäten in Deutschland nur zu etwa 6% ausgelastet. Vermutlich sind viele an anderen Krankheiten gestorben, weil die Bettenkapazitäten für potentielle COVID-19-Patienten reserviert worden waren (mussten). Von den wirtschaftlichen Auswirkungen und mittelbaren Kollateralschäden ganz zu schweigen.

Quellen

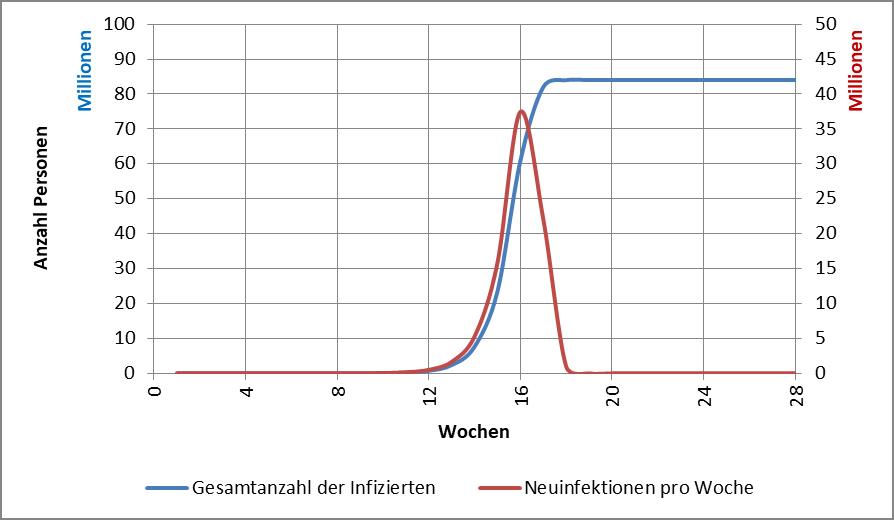

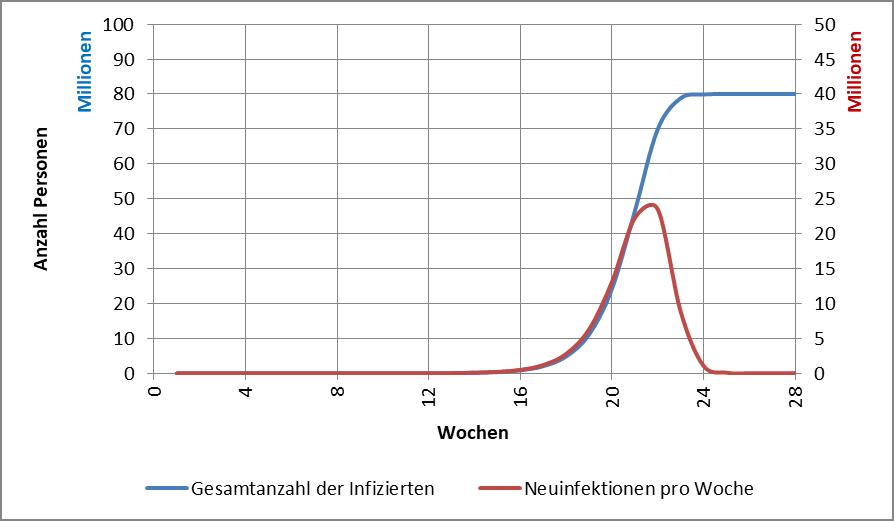

(Grafik 1: https://www.aerzteblatt.de/callback/image.asp?id=107167, Grafik 2: https://www.aerzteblatt.de/callback/image.asp?id=107168)

[10] Todesursachen – Zahl der Todesfälle. Statistisches Bundesamt

[11] Verteilung der häufigsten Todesursachen in Deutschland im Jahr 2018. Statista

[12] Bewegung senkt Sterberisiko um bis zu 40 Prozent. Universität Wien, 2011

Anhang

Begründung für die Annahme der Unabhängigkeit des effektiven COVID-19-Erkrankungs- und Sterberisikos von der Dunkelziffer bezüglich der Anzahl der Infizierten

Das Infektionsrisiko wird direkt durch die Anzahl der akut Infizierten determiniert. Die Dunkelziffer bezüglich der Anzahl der Infizierten führt daher unmittelbar zu einem entsprechenden Fehler bei der Bestimmung des Risikos. Das pauschale Infektionsrisiko wird nach der Formel

Infektionsrisiko = COVID-19-Infektiöse / Einwohnerzahl

berechnet. Doppelte Anzahl an Infizierten, heißt also auch doppeltes Infektionsrisiko.

Infektionsrisiko_RKI sei das Infektionsrisiko ohne Dunkelziffer, Infektionsrisiko_eff das effektive Infektionsrisiko inklusive der als bekannt gedachten Dunkelziffer.

Bekanntlich hat nicht jeder Infizierte ernsthafte Symptome. Nach den letzten Zahlen des RKI sind derzeit (KW 30 in 2020 und später), quer über alle Altersklassen maximal 10% der dokumentierten Infizierten hospitalisiert, also so krank, dass sie stationär behandelt werden müssen. Noch im April waren es 20% (s. Tabelle 2). Wir dürfen davon ausgehen, dass nahezu alle ernsthaft an COVID-19 Erkrankten in der Statistik erfasst werden. Demnach ist also die (absolute) Anzahl der COVID-19-Erkrankten vertrauenswürdig, nicht aber der (relative) Hospitalisierungsgrad, wie er vom RKI ausgewiesen wird.

Dazu folgende Überlegung:

COVID-19-Hospitalisierungsgrad_RKI = COVID-19-Erkrankte / COVID-19-Infizierte

Der Zähler ist verlässlich und fix, der Nenner stark mit Unsicherheit behaftet. Doppelt so viele Infizierte (Dunkelziffer), heißt daher halber Hospitalisierungsgrad.

Für Gesunde bleibt demnach das tatsächliche COVID-19-Erkrankungsrisiko unabhängig von der Unschärfe bezüglich der Anzahl der Infizierten. Bei der doppelten Anzahl an Infizierten aufgrund einer möglichen Dunkelziffer, verdoppelt sich zwar das effektive Infektionsrisiko, das wird aber kompensiert durch den in entsprechendem Maße halbierten effektiven Hospitalisierungsgrad, denn die absolute Anzahl der Hospitalisierten liegt fest:

Infektionsrisiko_eff * COVID-19-Hospitalisierungsgrad_eff = Infektionsrisiko_RKI * COVID-19-Hospitalisierungsgrad_RKI

Ähnlich verhält es sich mit dem COVID-19-Sterberisiko. Das vom RKI ausgewiesene spezifische COVID-19-Sterberisiko (Letalität) liegt seit Mitte des Jahres bei unter 1% mit weiter sinkender Tendenz (s. Tabelle 2). Es ist wie folgt definiert:

COVID-19-Sterberisiko = COVID-19-Todesfälle / COVID-19-Infizierte

(jeweils bezogen auf gleiche Zeitabschnitte).

Auch hier dürfen wir wieder davon ausgehen, dass die validen COVID-19 Todesfälle nahezu vollständig in der Statistik des RKI dokumentiert sind. Für Gesunde bleibt daher das effektive COVID-19-Sterberisiko unbeeinflusst von der Unsicherheit bezüglich der Dunkelziffer der Infizierten. Bei der im Beispiel doppelten Anzahl an Infizierten, verdoppelt sich das Infektionsrisiko. Das wird kompensiert durch das dann in gleichem Maße halbierte effektive COVID-19-Sterberisiko, denn die absolute Anzahl der Sterbefälle liegt fest:

Infektionsrisiko_eff * COVID-19-Sterberisiko_eff = Infektionsrisiko_RKI * COVID-19-Sterberisiko_RKI

Insgesamt dürfen wir daher sowohl beim Erkrankungsrisiko (Hospitalisierungsgrad) als auch beim Sterberisiko (Letalität) die absoluten Zahlen des RKI unmittelbar verwenden. Gleichviel, wie hoch die Anzahl der COVID-19-Infizierten tatsächlich ist (Dunkelziffer) und wie viele Falsch-Positive darunter auch sein mögen: bezogen auf das Erkrankungs- und Sterberisiko für die Gesamtpopulation ändert sich dadurch nichts. Entscheidend für das effektiv bestehende Risiko sind ausschließlich die absoluten Zahlen bezüglich der Hospitalisierung und der spezifischen COVID-19-Todesfälle.