Teil 5 der Reihe „Energiewende und Wärmepumpe“

Zusammenfassung

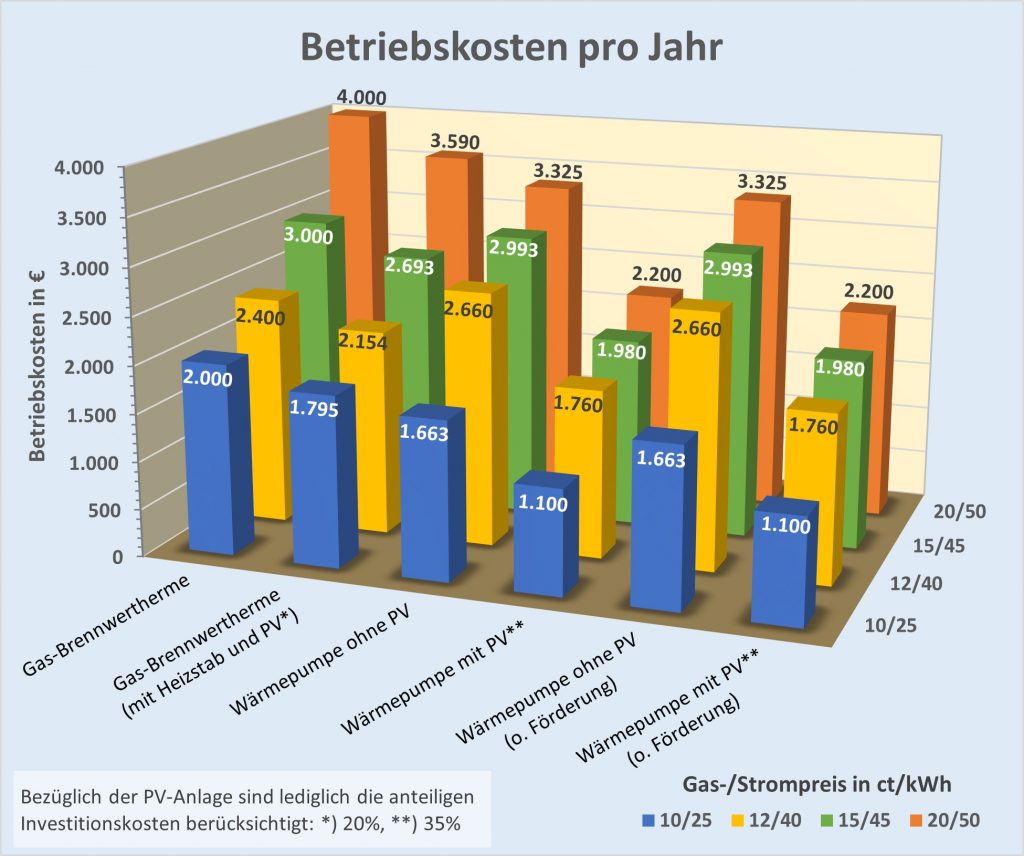

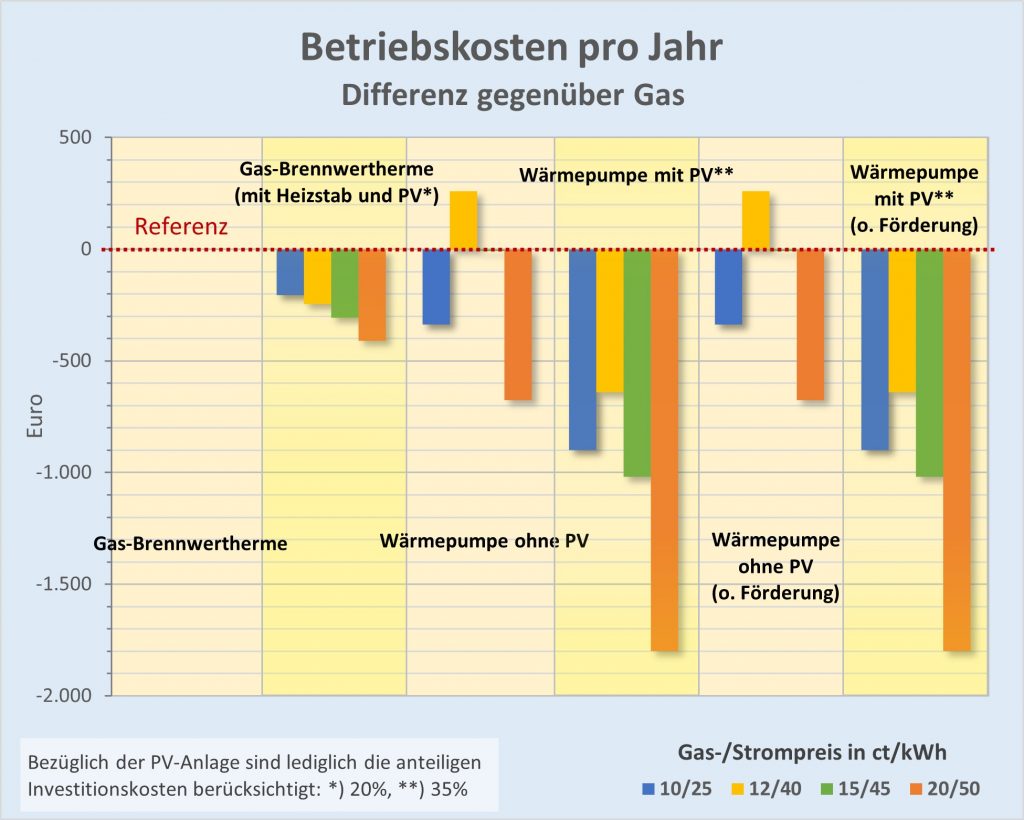

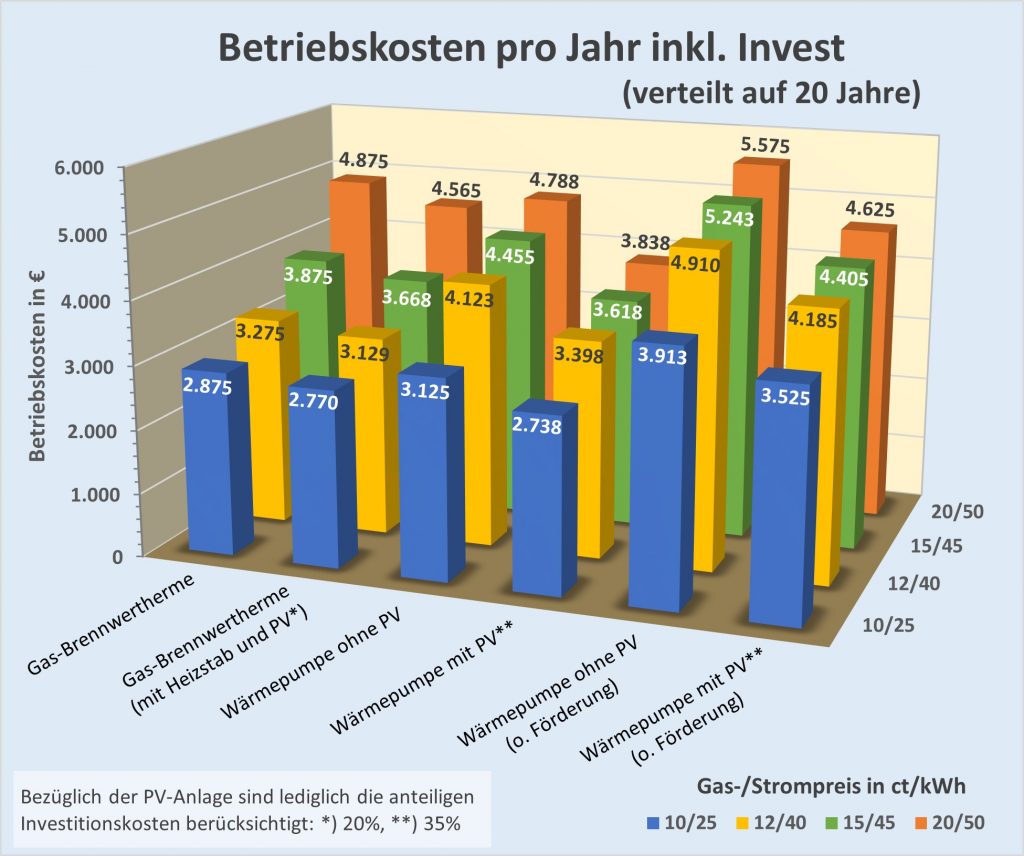

Über den konkret betrachteten Fall hinaus werden grundsätzliche Überlegungen zur Wirtschaftlichkeit von Wärmepumpen gegenüber Gas-Brennwertthermen angestellt. Ferner werden Wirtschaftlichkeitskriterien mit und ohne Investition sowie mit und ohne Einsatz von Photovoltaik formuliert.

Einleitung

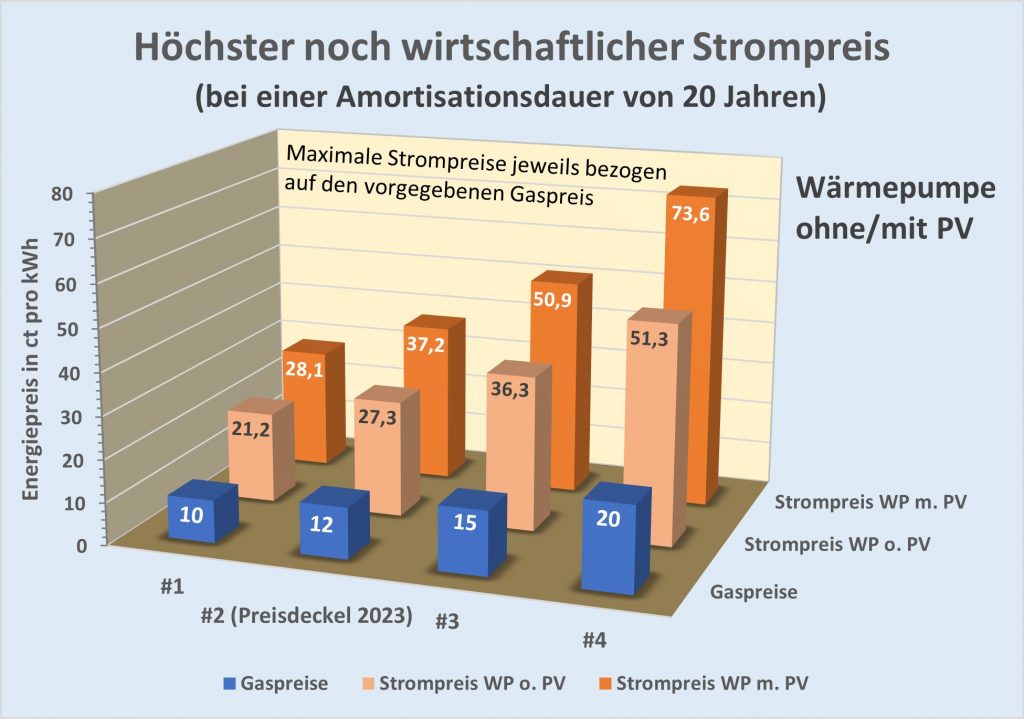

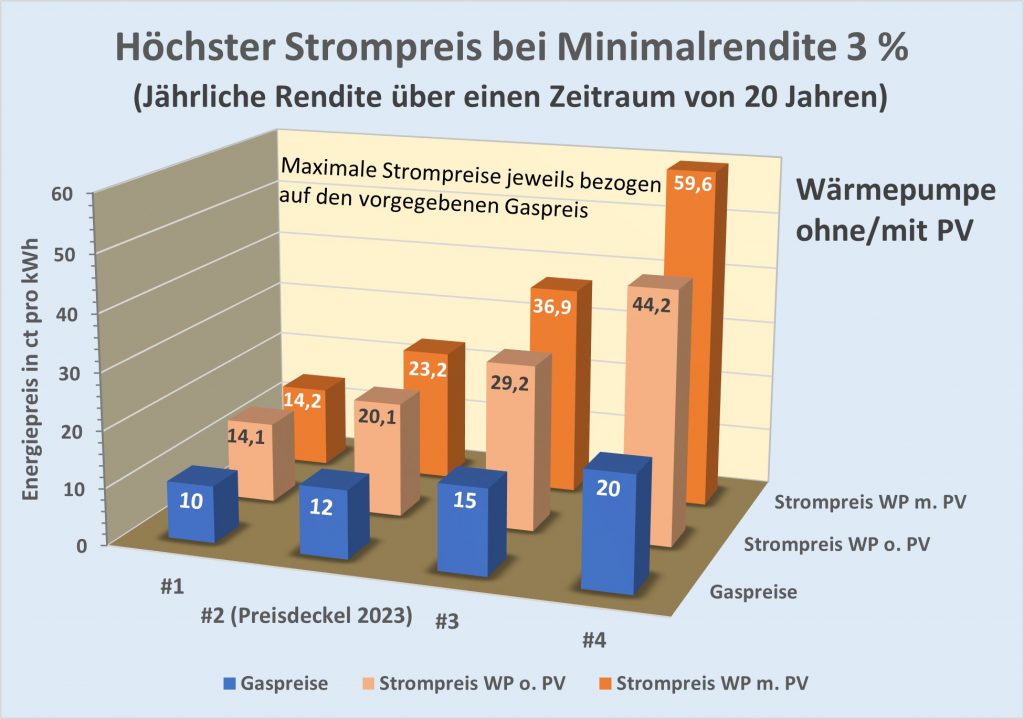

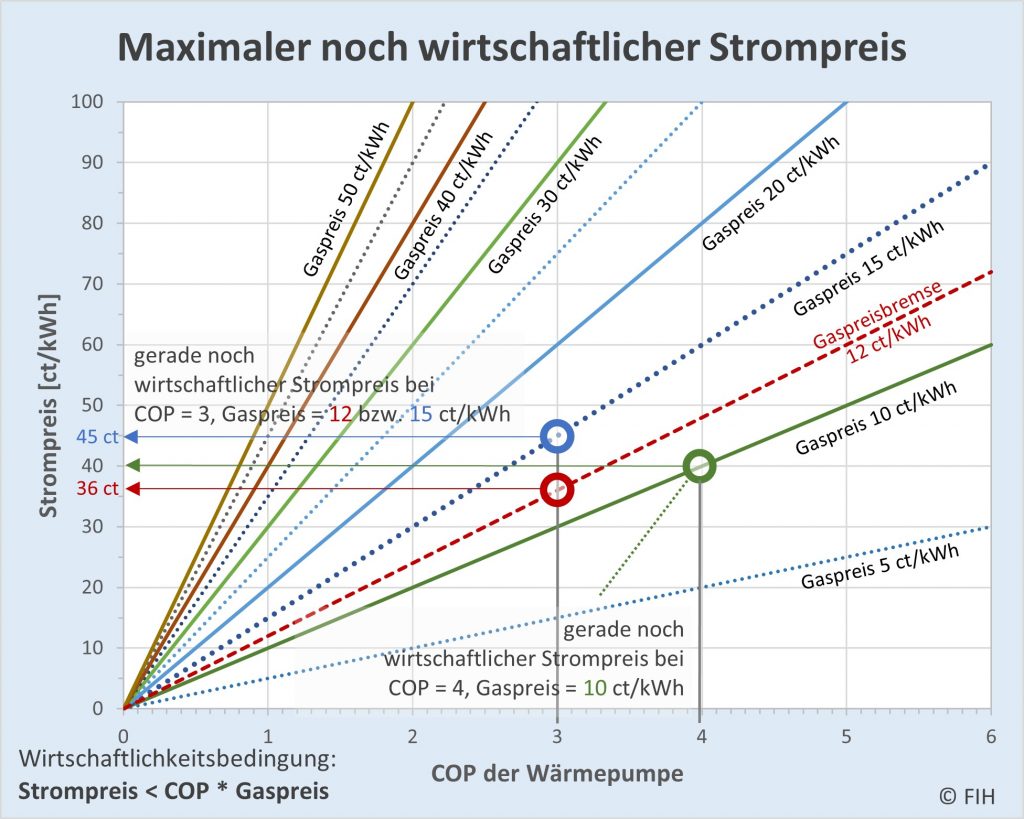

Aus den in Teil 4 (Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnung) beispielhaft durchgerechneten Fällen ergibt sich unmittelbar, dass der relevante Strompreis bzw. das Verhältnis zwischen dem Gas- und dem Strompreis die Wirtschaftlichkeit direkt bestimmt. Das gilt natürlich unabhängig vom Einzelfall ganz generell auch für andere Objekte und Wärmepumpen. Fokussiert man sich zunächst nur auf die Betriebskosten, so haben wir die folgende ganz einfache Formel zur Bestimmung des höchsten gerade noch wirtschaftlichen Strompreises:

(1)

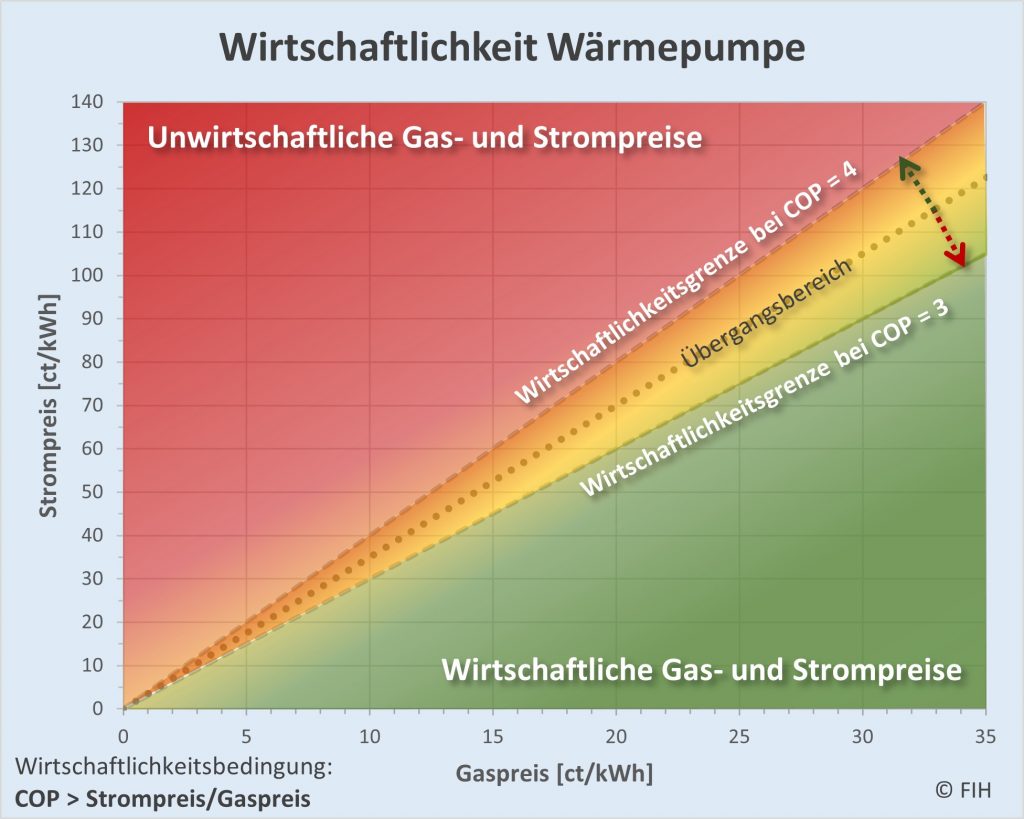

In der nachfolgenden Abbildung ist der Zusammenhang grafisch aufbereitet.

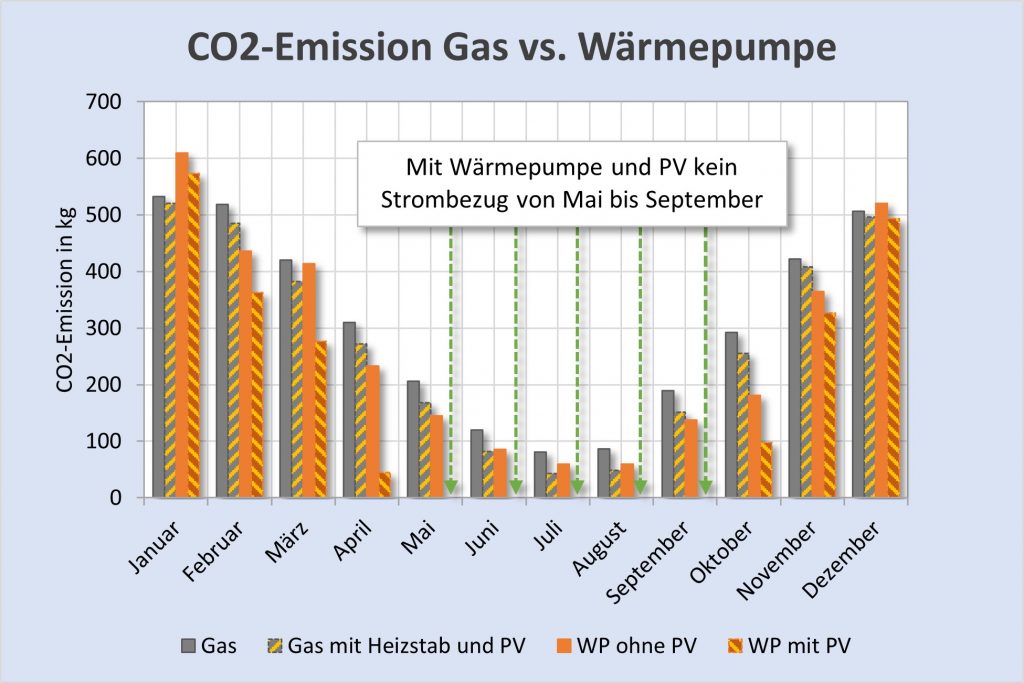

Abbildung 5-1: Höchster noch wirtschaftlicher Strompreis beim Betrieb von Wärmepumpen in Abhängigkeit vom COP-Wert. Betrachtet werden hier nur die Betriebskosten im Vergleich zu einer Gasheizung (ohne eventuell erforderliche Investitionen). Bei gegebenem Wärmepumpen-COP kann man dem Diagramm unmittelbar den höchsten gerade noch wirtschaftlichen Strompreis im Vergleich zur Heizung mit Gas entnehmen. Beispiel: COP = 3, Gaspreis = 12 ct/kWh; der Strompreis darf in diesem Fall den Wert von 36 ct/kWh nicht übersteigen, andernfalls fallen die Betriebskosten höher aus als bei der Beheizung mit Gas.

Aus der Formel und dem Diagramm ergibt sich, dass eine Wärmepumpe mit einem COP-Wert von 3 bei den derzeitigen Gaspreisen zwischen 10 und 15 ct/kWh nur bei Strompreisen unterhalb von 30 bzw. 45 ct/kWh wirtschaftlich betrieben werden kann. Bei einem COP-Wert von 4 liegen die höchsten noch wirtschaftlichen Strompreise bei 40 bzw. 60 ct/kWh. Dabei muss man indessen berücksichtigen, dass in der Praxis auch noch die Investitionskosten hinzukommen. Dazu weiter unten.

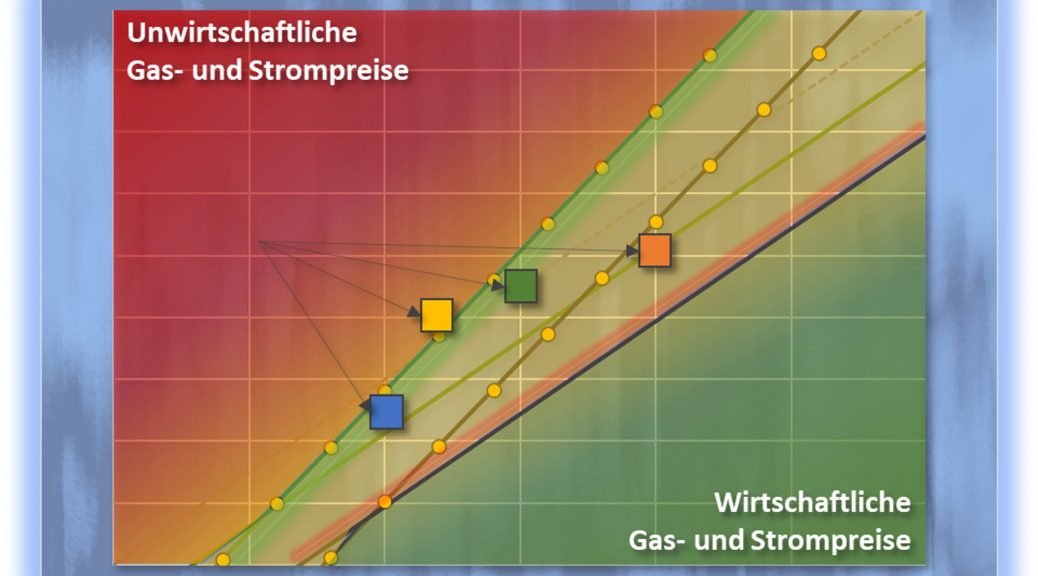

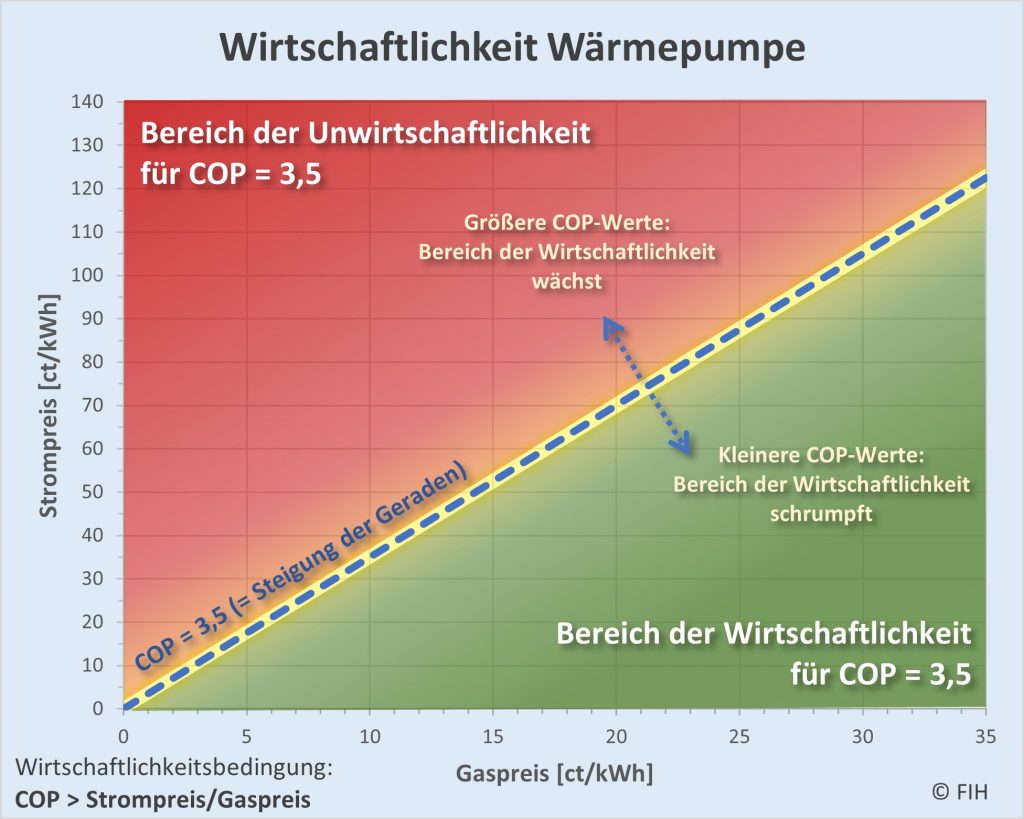

Grundsätzlich entscheidet nach dem Vorstehenden der COP-Wert darüber, ob eine gegebene Kombination von Strom und Gaspreisen überhaupt einen wirtschaftlichen Betrieb der Wärmepumpe erlaubt. In der nachfolgenden Abbildung ist das exemplarisch für einen COP-Wert von 3,5 dargestellt.

Wirtschaftlichkeitskriterium ohne Berücksichtigung der Investitionen

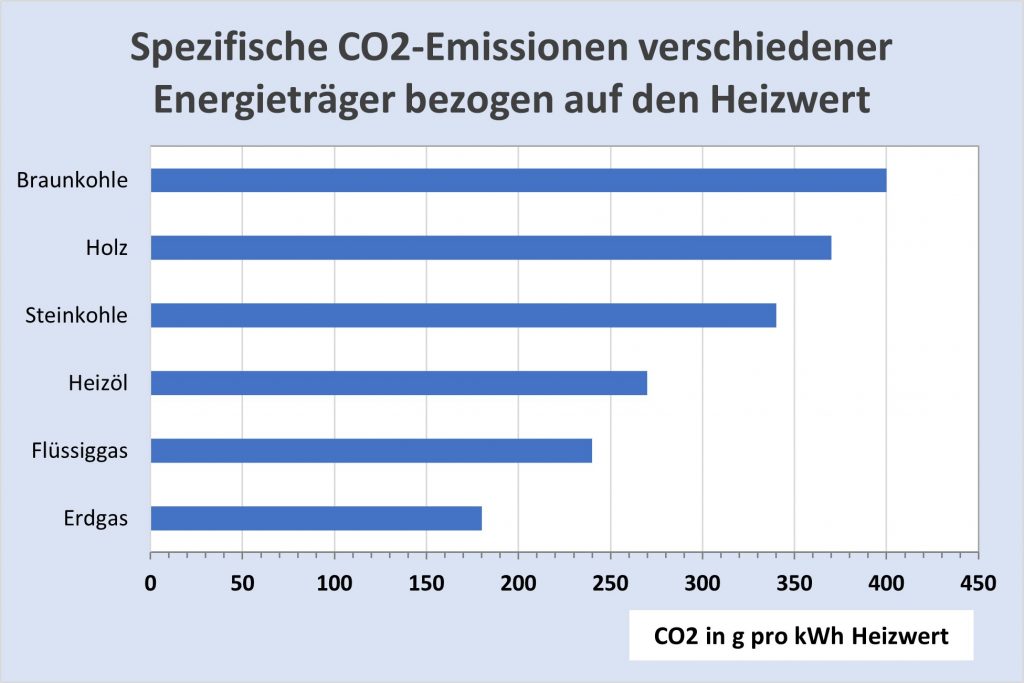

Die Frage der Wirtschaftlichkeit steht immer in Zusammenhang mit den möglichen Alternativen. Es macht Sinn, diesbezüglich insbesondere den Vergleich mit der Gasheizung in den Blick zu nehmen. Selbstverständlich wäre es in gleicher Weise möglich, stattdessen oder auch zusätzlich andere Energieträger zu betrachten, z.B. Öl- oder Pelletheizungen. Wir fokussieren uns hier auf Gas. Die prinzipiellen Beziehungen sind indessen auch im Vergleich zu jeder anderen Alternative gültig.

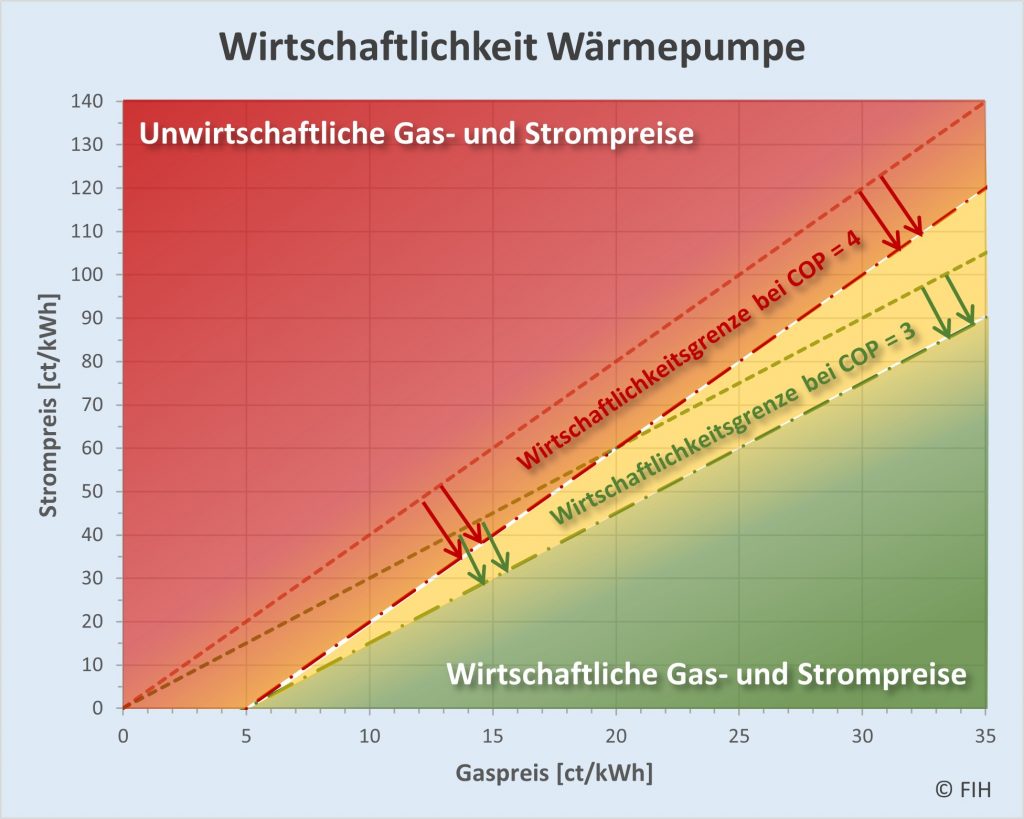

Abbildung 5-2: Wirtschaftlichkeit von Wärmepumpen in Abhängigkeit vom Verhältnis Strompreis zu Gaspreis. Betrachtet werden hier nur die Betriebskosten im Vergleich zu einer Gasheizung (ohne die erforderlichen Investitionen und ohne Eigenstromnutzung von einer evtl. vorhandenen Photovoltaik-Anlage).

Die allgemeine Wirtschaftlichkeitsbedingung lautet:

(2)

Wirtschaftlichkeitsbetrachtung für die praxisrelevanten COP-Werte

Entscheidend für die Wirtschaftlichkeit ist also der effektive Wärmepumpen-COP in der Relation zum Verhältnis Strompreis zur Gaspreis. Im nachfolgenden Diagramm wird das im Hinblick auf die praktische Anwendung nochmals grafisch hervorgehoben.

Abbildung 5-3: Wirtschaftlichkeit von Wärmepumpen in Abhängigkeit vom Verhältnis Strompreis zu Gaspreis. Betrachtet werden hier nur die Betriebskosten im Vergleich zu einer Gasheizung (ohne die erforderlichen Investitionen und ohne Eigenstromnutzung von einer evtl. vorhandenen Photovoltaik-Anlage).

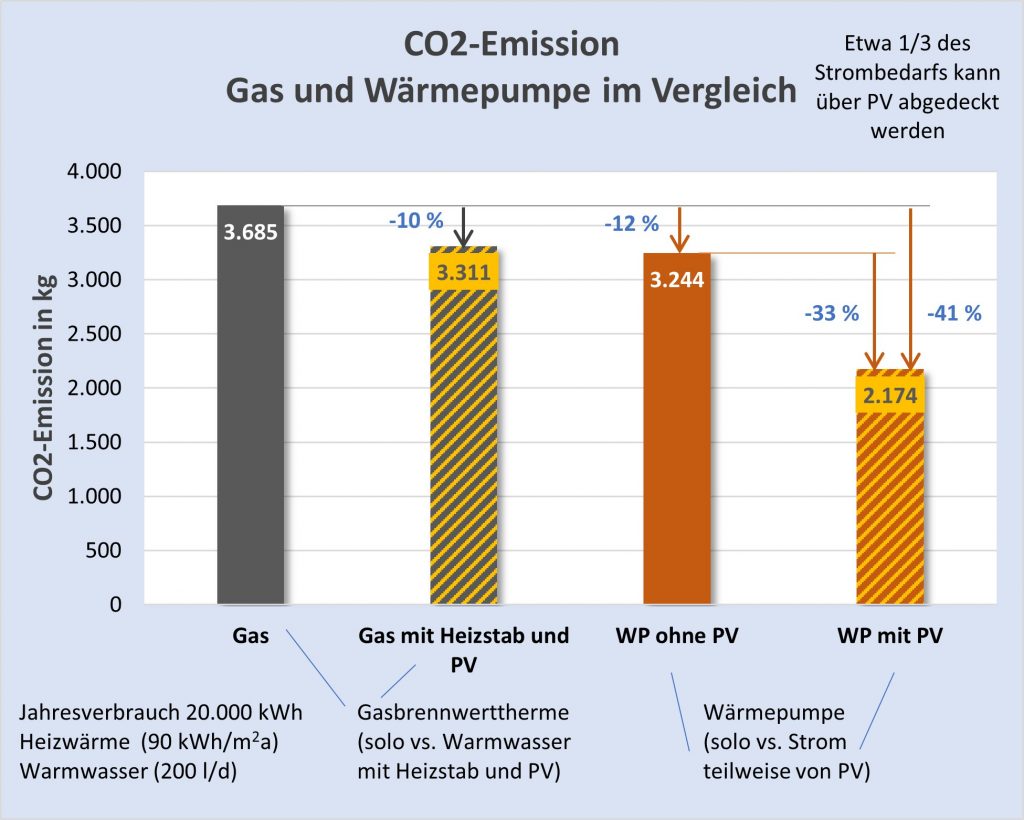

Die meisten Wärmepumpen arbeiten in der Praxis mit einem COP-Wert zwischen etwa 2,5 und 4,5. Nach einer Fraunhofer-Studie aus 2022 (s. [8]) liegen die COP-Werte in Bestandsgebäuden bei einem Mittelwert von 3,1. Daher ist die in Teil 3 (CO2-Emissionen von Gasheizung und Wärmepumpe? Vergleich für ein Bestandsgebäude) und Teil 4 (Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnung) durchgeführte Berechnung auf Basis eines exemplarischen COP von 3 absolut realitätsnah. Der gelbe Keil im Diagramm markiert den interessierenden Bereich zwischen COP 3 und COP 4.

Da also die praxisbezogenen COP-Werte vielfach zwischen etwa 3 und 4 liegen, sind Wärmepumpen i.A. unwirtschaftlich, sofern der Strompreis mindestens viermal höher ist als der Gaspreis (rot markierter Bereich in der Grafik). Umgekehrt ist die Wirtschaftlichkeit meist gegeben, wenn der Strompreis maximal etwa dreimal höher ist als der Gaspreis (grün eingefärbter Bereich). Im dazwischenliegenden keilförmigen Bereich (gelb hervorgehobenen) muss man genau vergleichen, wie der reale COP in Relation zum Verhältnis Strompreis zu Gaspreis liegt.

Das ist die Beurteilung ohne Berücksichtigung der Investitionen die indes durchaus erheblich sein können, wie wir in Teil 4 (Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnung) gesehen haben.

Wirtschaftlichkeitskriterium mit Berücksichtigung der Investitionen

Sofern man auch die Investitionskosten ins Kalkül nehmen will, muss man die beiden gestrichelten Geraden von Abb. 5-3 in Abhängigkeit von der Höhe der Kosten und der angenommenen Betriebszeit parallel nach unten verschieben. Im Ergebnis wird damit der Wirtschaftlichkeitsbereich (im Diagramm grün eingefärbt) weiter beschnitten und der Übergangsbereich eingeengt.

Abbildung 5-4: Wirtschaftlichkeit von Wärmepumpen in Abhängigkeit vom Verhältnis Strompreis zu Gaspreis unter Berücksichtigung der Betriebskosten und der Investitionen (ohne Eigenstromnutzung von einer vorhandenen Photovoltaik-Anlage). Die Investitionskosten wirken wie eine Parallelverschiebung der betreffenden durch den COP-Wert bestimmten Grenzgeraden nach unten. Dadurch schrumpft der Wirtschaftlichkeitsbereich. D.h., beim gleichen Gaspreis sinkt der maximal noch ökonomische Strompreis.

Mit den Definitionen

(3)

lautet daher das erweiterte Wirtschaftlichkeitskriterium unter Einbeziehung der Investitionen:

(4)

Präzise formuliert ist die Zusatzinvestition für die Wärmepumpe gegenüber der Gasheizung.

Das vorstehende Kriterium ergibt sich aus der unmittelbar einleuchtenden Relation

(5)

Das Wirtschaftlichkeitskriterium bei Solarstromnutzung

Wir vernachlässigen die Betriebskosten der Photovoltaikanlage und bezeichnen die Höhe des PV-Anteils am erforderlichen Wärmepumpenstrom mit . Die Eigenstromnutzung wirkt im Hinblick auf die Wirtschaftlichkeit wie eine Strompreisreduzierung um den Anteil

. Das Wirtschaftlichkeitskriterium wird daher zu

(6)

Man kann das auch dahingehend interpretieren, dass der PV-Anteil zu einer hypothetischen Steigerung des COP-Wertes der Wärmepumpe führt. Bei einem PV-Anteil von 1/3 erhöht sich der COP-Wert fiktiv um 50 %, z.B. von 3 auf 4,5.

Das finale Wirtschaftlichkeitskriterium

Das Kriterium kann noch etwas eleganter formuliert werden, wenn man die Höhe der erforderlichen Zusatzinvestitionen auf die Anzahl der Betriebsjahre umrechnet und in Einheiten der jährlichen Heizenergiekosten (mit Gas) ausdrückt. Für den solchermaßen definierten Investitionsquotienten

gilt folglich

(7)

Damit erhalten wir das finale Wirtschaftlichkeitskriterium:

(8)

Der Quotient rechts gibt an, um welchen Faktor der COP-Wert der Wärmepumpe größer sein muss bzw. kleiner sein darf als das Verhältnis Strompreis zu Gaspreis. In dieser Form ist daher das Kriterium generisch auf jede Preiskonstellation mit und ohne Solarstromnutzung sowie mit und ohne Berücksichtigung von Investitionen unmittelbar anwendbar.

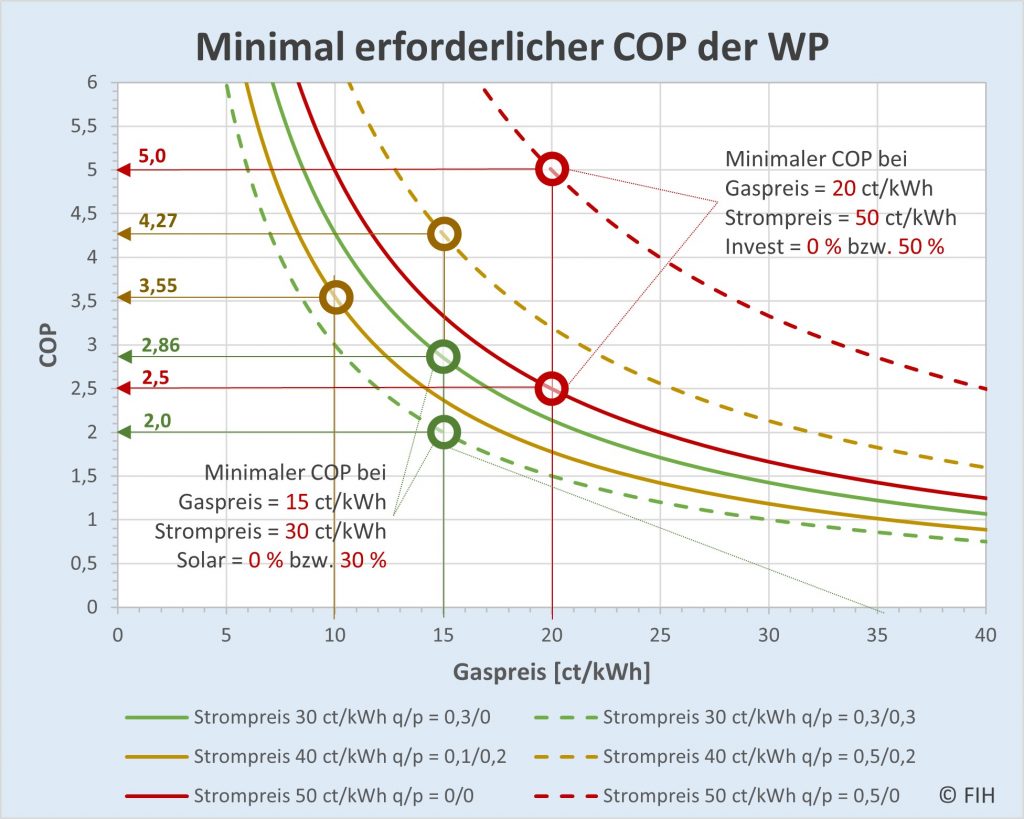

In Abb. 5-5 wird die Wirkung der Formelbeziehung beispielhaft erläutert.

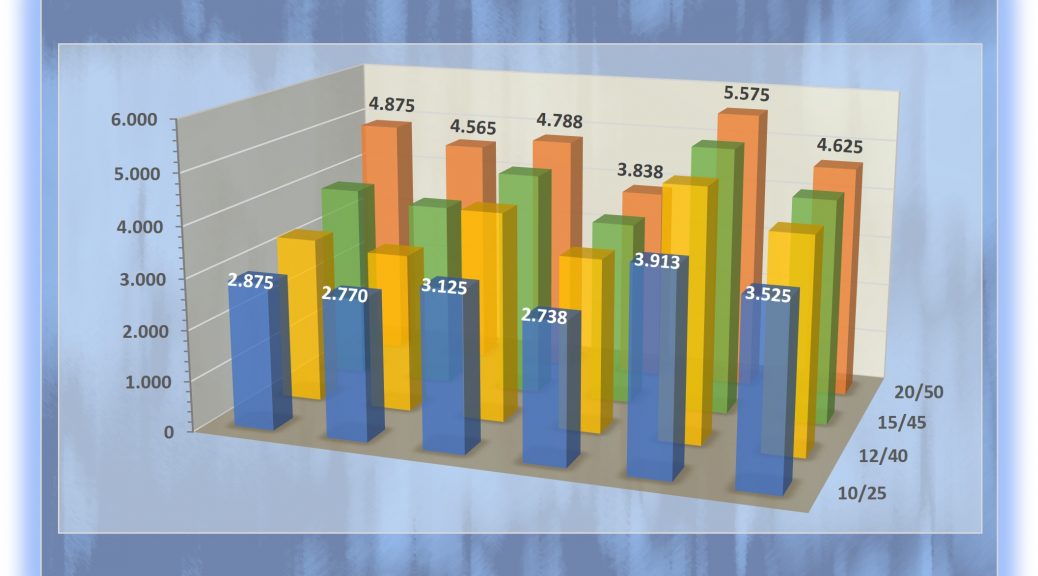

Abbildung 5-5: Exemplarische Kurvenschar zum finalen Wirtschaftlichkeitskriterium. Zu einem gegebenen Gaspreis gibt das Diagramm für unterschiedliche Strompreise und Investitionsquotienten q = q_Invest sowie PV-Eigenstromanteile p = p_Solar den jeweils minimal erforderlichen COP-Wert der Wärmepumpe an. Die beispielhaft hervorgehobenen Gas-/Strompreis-Kombinationen 15/30 (grün) und 20/50 (rot) sind im Diagramm erläutert. Der linke braune Kreis markiert die Kombination Gaspreis = 10 ct/kWh, Strompreis = 40 ct/kWh bei einem Investitionsquotienten q = 10 % und einem Solarstromanteil p = 20 %. Der rechte braune Kreis steht beim gleichen Strompreis und dem gleichen Solarstromanteil für die Kombination mit dem Gaspreis = 15 ct/kWh und dem höheren Investitionsquotienten q = 50 %.

Der Darstellung kann man entnehmen, welch starken Einfluss die Größe des Investitionsquotienten hat. Bei einem Gaspreis von 20 ct/kWh ist die Wärmepumpe unter Vernachlässigung der Investitionen bereits mit einem COP-Wert von 2,5 wirtschaftlich (untere rote Markierung bei 20). Sofern der Investitionsquotient 50 % beträgt, ist schon ein COP-Wert von 5 erforderlich. Dieser negative Effekt kann indessen durch einen entsprechend hohen Solarstromanteil kompensiert werden. Das sieht man z.B. bei den grünen Markierungen (Gaspreis 10 ct/kWh, Strompreis 30 ct/kWh). Der im Falle der gestrichelten grünen Linie höhere Solarstromanteil von 30 % führt bei gleichem Invest zu einer Verringerung des nötigen COP-Wertes von 2,86 auf 2,0.

Generische Formulierung des Wirtschaftlichkeitskriteriums

In der formulierten Ökonomiebedingung sind letztlich nur drei Größen relevant: Das Verhältnis Strompreis zu Gaspreis, der Investitionsquotient q und der Solarstromanteil p. Das kann man dazu nutzen, den Zusammenhang mit dem COP-Wert ohne direkten Bezug auf den Gas-und Strompreis kompakt in einem Diagramm darzustellen.

In der Praxis wird man sich dabei die Frage stellen, um welchen Prozentanteil der COP-Wert ggf. höher ausfallen muss (Aufschlag zum COP), bzw. niedriger sein darf (Abschlag vom COP) als der Vergleichswert bei q = 0 und p = 0. Das kommt in der Beziehung

(9)

zum Ausdruck, wobei

(10)

Die Bedingung lautet somit

(11)

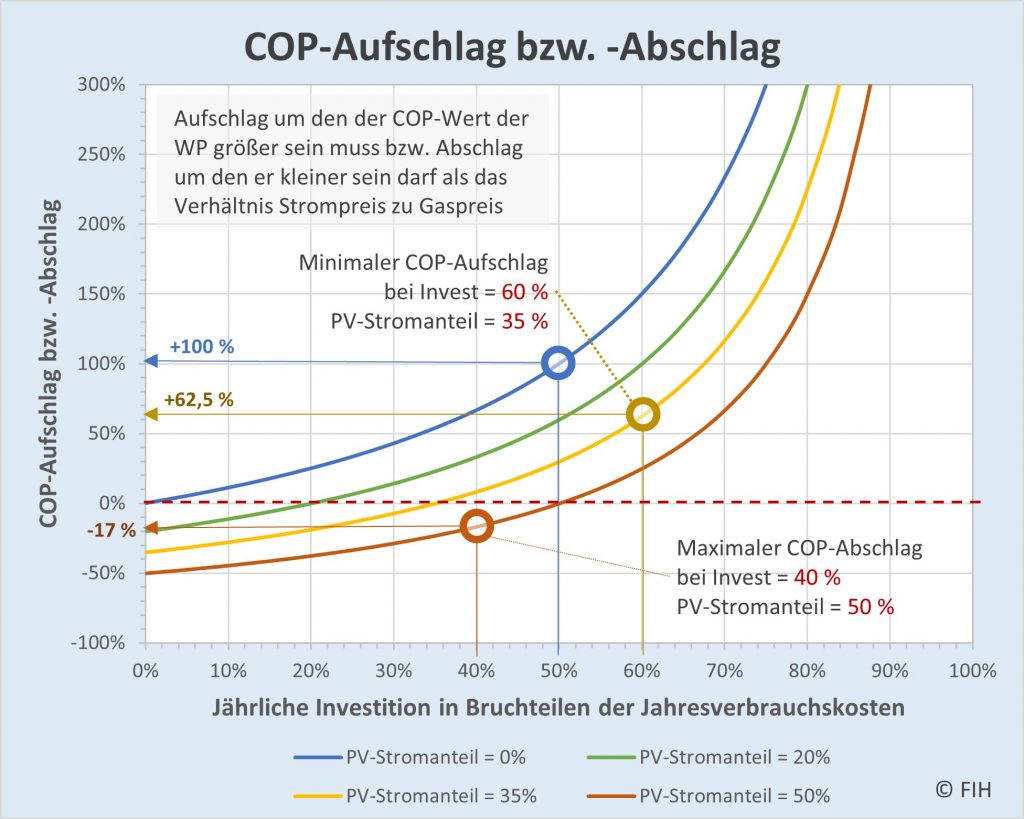

Im nachfolgenden Diagramm ist der Verlauf von , also die relative Änderung des

in Abhängigkeit vom Investitionsquotienen q für verschiedene Solarstromanteile p dargestellt.

Abbildung 5-6: Exemplarische Kurvenschar zum generischen Wirtschaftlichkeitskriterium. Auf der x-Achse ist der Investitionsquotient q = q_Invest aufgetragen. Für vier unterschiedliche PV-Eigenstromanteile p = p_Solar sind die entsprechenden Kurvenverläufe eingezeichnet. Beispiel: Gelber Kreis bei der Kurve mit dem Solarstromanteil p = 35 % und dem Investitionsquotienten q = 60 %. In diesem Falle muss der COP-Wert um mindestens 62,5 % höher sein als das Verhältnis Strompreis zu Gaspreis.

Das Diagramm macht deutlich, wie die Investitionskosten und die mögliche Solarstromnutzung zusammenwirken. Höhere Investitionsquotienten führen schnell zu merklichen Aufschlägen auf den erforderlichen Mindest-COP-Wert. Abgemildert wird das nur durch entsprechend größere Nutzungsanteile beim Solarstrom. Diese ungünstige Auswirkung der Investitionen kann sogar umgedreht werden. Das sieht man exemplarisch im Falle der orangefarbenen Markierung. Bei einem Investitionsquotienten q = 40 % und einem Solarstromanteil p = 50 % erhält man im Ergebnis eine Minderung des minmal erforderlichen COP-Wertes von 17 %. Konkret wäre so z.B. auch ein COP von 2,49 bei einem Strom-/Gaspreisverhältnis von 3:1 noch hinreichend (2,49 = 3*(1-0,17)).

Diskussion zur Wirtschaftlichkeit

Den vorstehenden Formelbeziehungen entnimmt man ohne Weiteres, dass eine kürzere Betriebsdauer in die selbe Richtung wirkt, wie eine höhere Investition und daher zu einer Parallelverschiebung der Grenzgeraden nach unten führt. Im Ergebnis schrumpft demnach auch in diesem Falle der Bereich wirtschaftlicher Strom-Gaspreis-Kombinationen hin zu kleineren Strom- bzw. höheren Gaspreisen.

Völlig analog verhält es sich, wenn der Jahresverbrauch sinkt. Wir haben daher die scheinbar paradoxe Situation, dass die Wärmepumpe umso weniger wirtschaftlich ist, je kleiner die Jahresverbräuche ausfallen. Das ist natürlich nur auf den ersten Blick ein Widerspruch, denn begreiflicherweise fallen bei einem niedrigeren Verbrauch die Investitionen stärker ins Gewicht während zugleich das Einsparpotential auf Seiten der Betriebskosten immer geringer wird.

Grenzbetrachtung für verschwindende Stromkosten

Bei gegebenen Werten für den Gaspreis, die Betriebsdauer der Wärmepumpe und den Jahresverbrauch erhalten wir das folgende Kriterium für die Höhe der im Grenzfall verschwindender Stromkosten (also Strompreis = 0) gerade noch wirtschaftlichen Grenzinvestitionssumme :

(12)

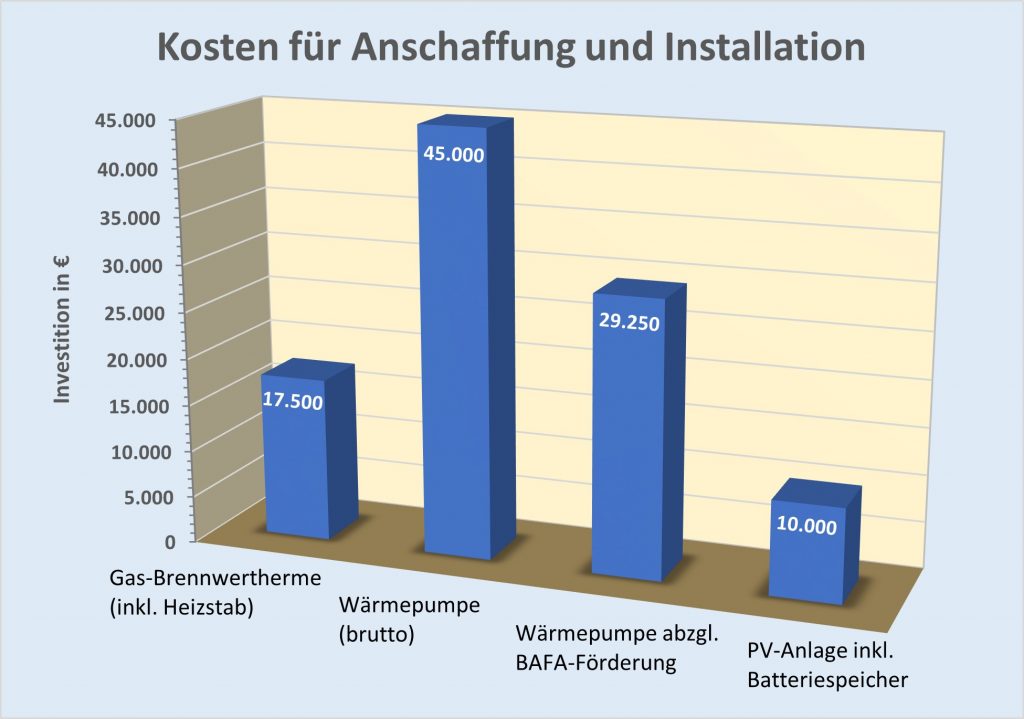

Beispiel: Gaspreis = 12 ct/kWh, Jahresverbrauch = 10.000 kWh, Betriebsdauer = 20 Jahre, Grenzinvestition = 24.000 €. Bei einem Jahresverbrauch von 20.000 kWh ist die Grenzinvestition mit 48.000 € doppelt so hoch. Wohlgemerkt, das gilt bei einem hypothetischen Strompreis von 0 bzw. bei einem PV-Anteil von 100 % (respektive einem unendlich hohen COP-Wert).

Grenzbetrachtung für reale Stromkosten

Bei gegebenem Strompreis > 0 und realem COP-Faktor liegt die wirtschaftlich gerade noch vertretbare rechnerische Grenze für die Höhe des Investitionsbetrags bei

(13)

Beispiel: Gaspreis = 12 ct/kWh, Strompreis 30 ct/kWh, PV-Anteil = 0 %, Jahresverbrauch = 10.000 kWh, Betriebsdauer = 20 Jahre, Grenzinvestition = 4.000 €. Bei einem Jahresverbrauch von 20.000 kWh kommt die Grenzinvestition mit 8.000 € wieder doppelt so hoch. Erhöht sich der Strompreis auf 42 ct/kWh, so sinkt dadurch die hypothetische Grenzinvestition auf -8.000 €, es wird also bereits signifikant unwirtschaftlich.

Wann sich Investitionen definitiv nicht lohnen

Im Grenzfall

(14)

verbieten sich aus wirtschaftlicher Sicht jegliche Investitionen, da die rechnerische Grenzinvestition in der Formel null wird. Bei noch kleineren COP-Werten wird sie sogar negativ.

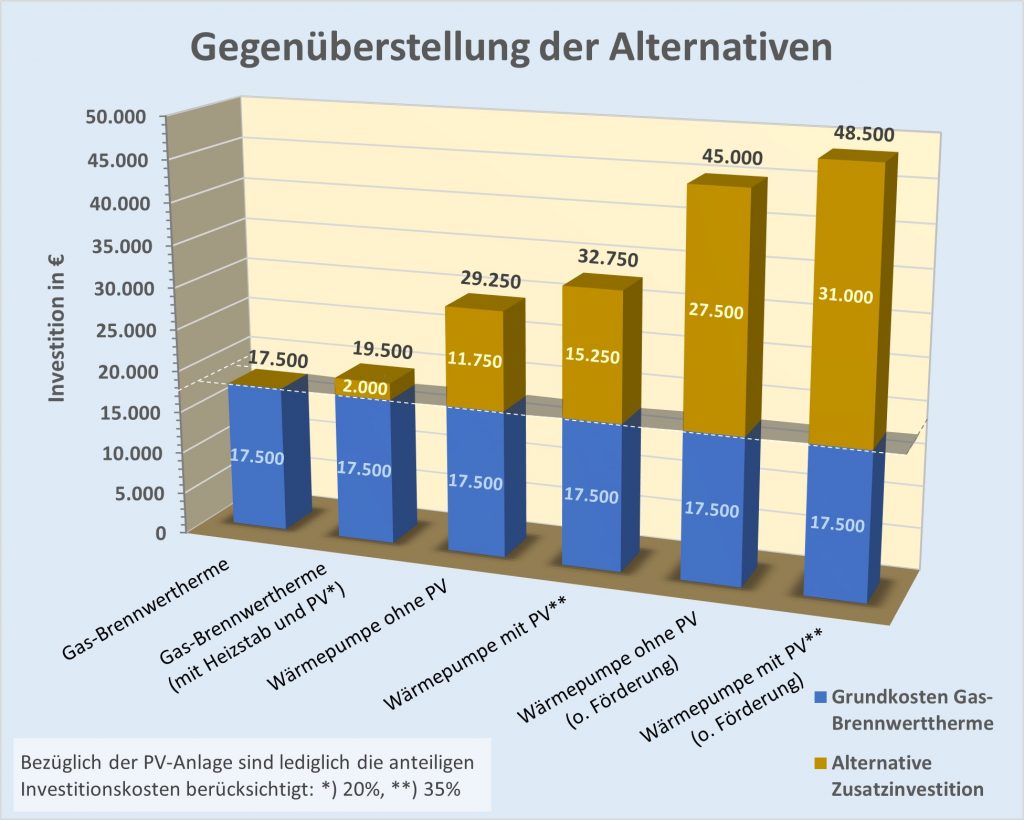

Die exemplarischen Fälle im weiteren Kontext

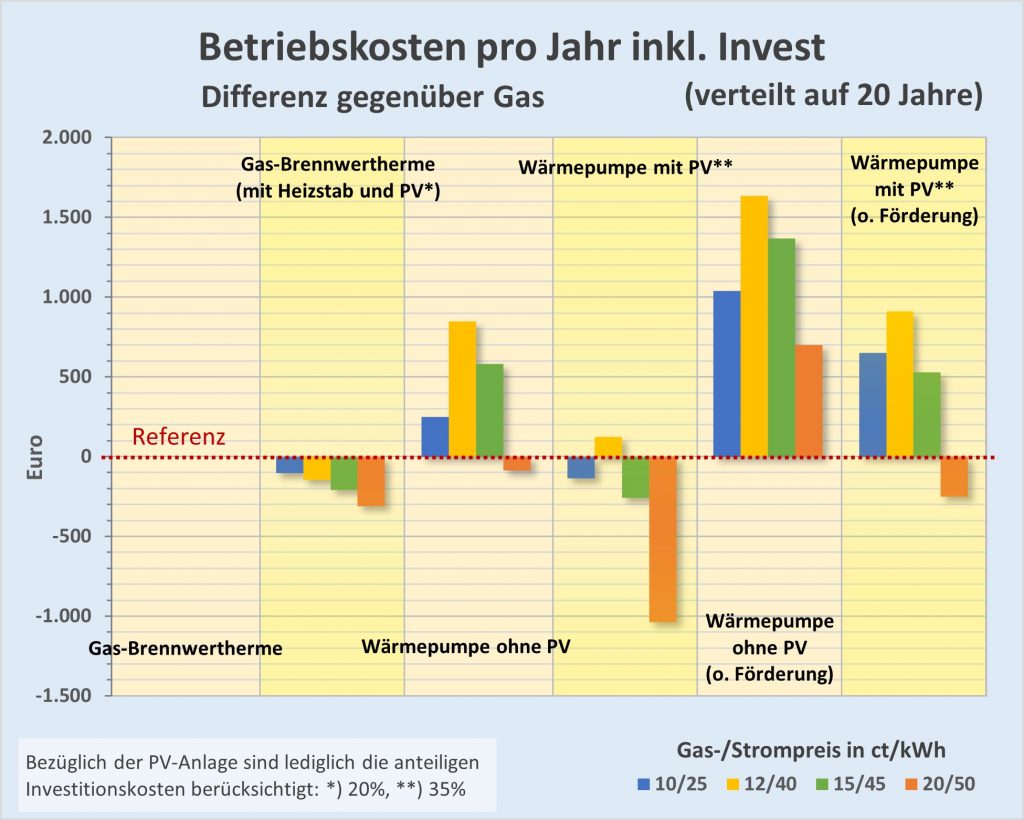

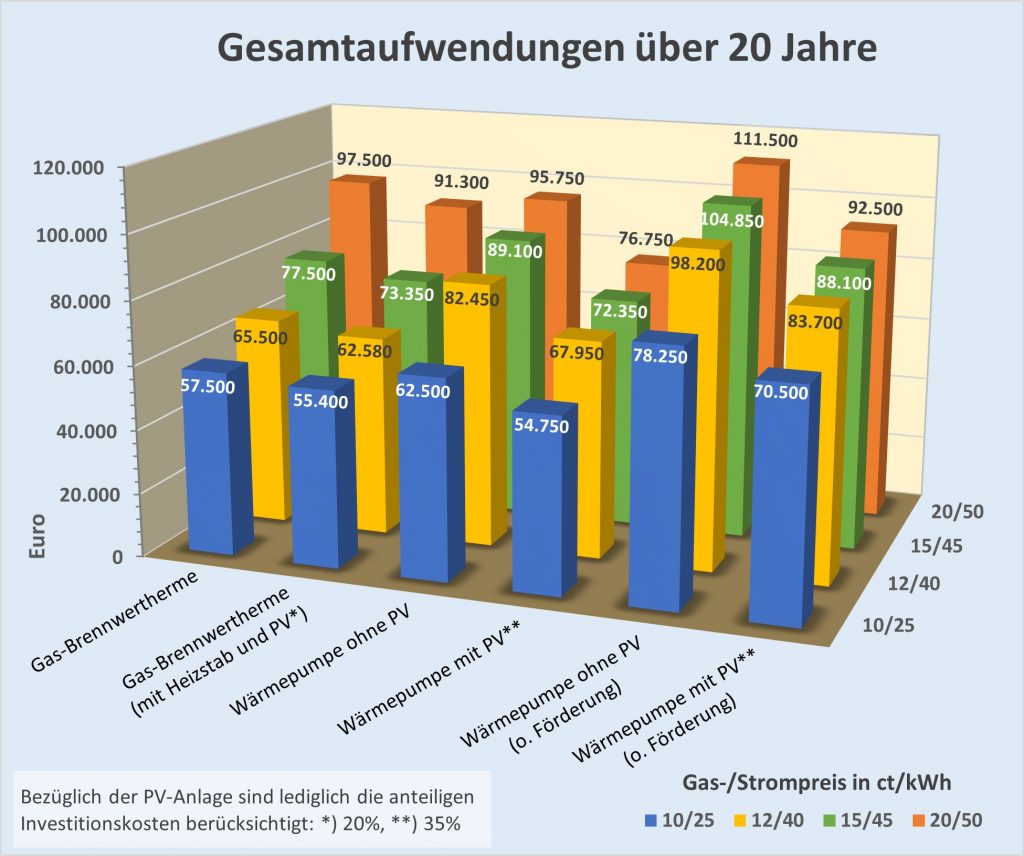

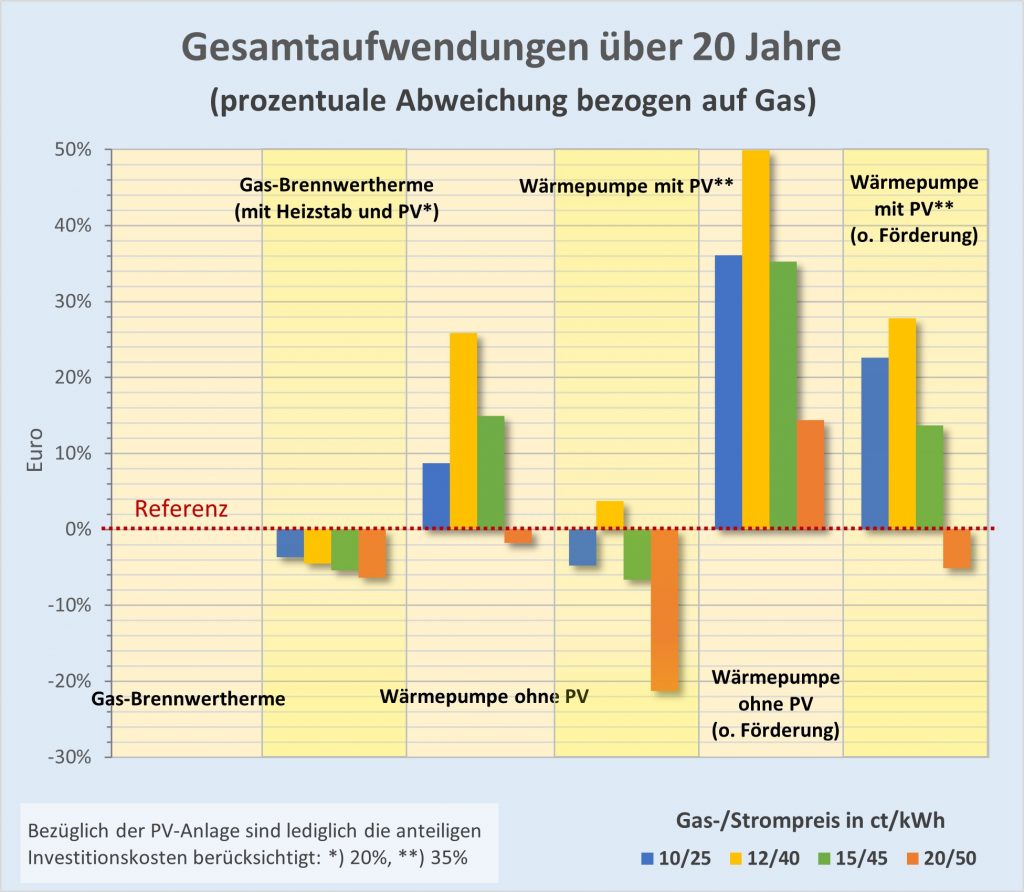

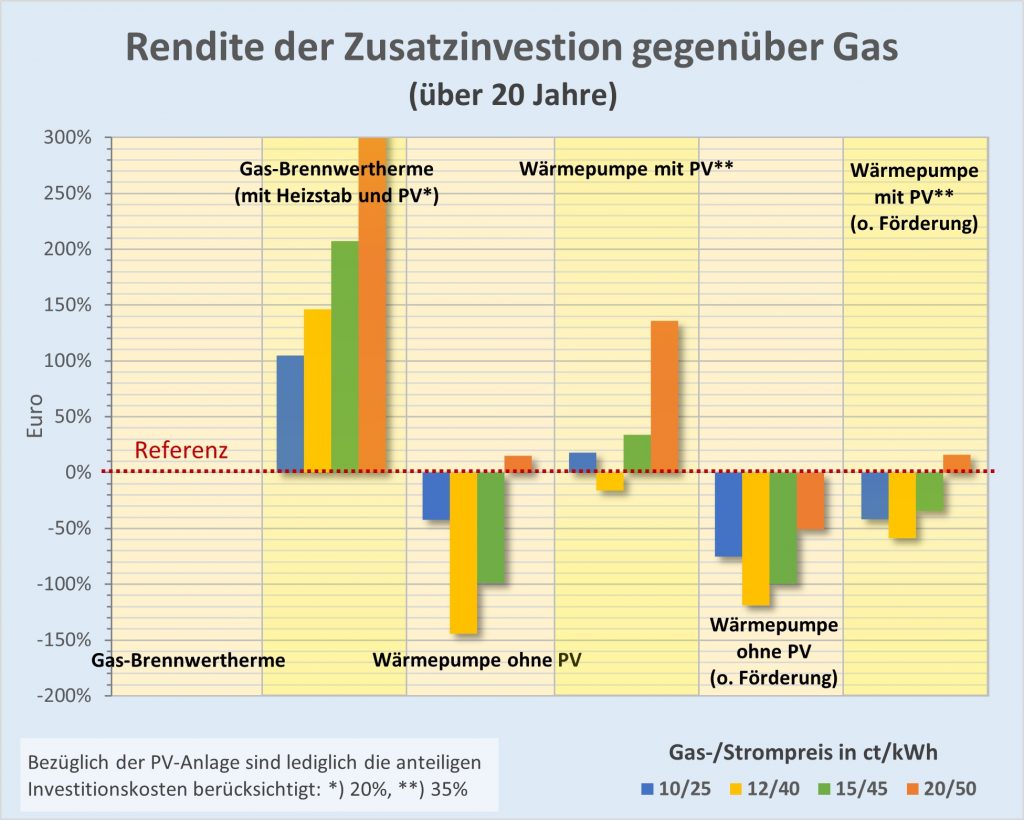

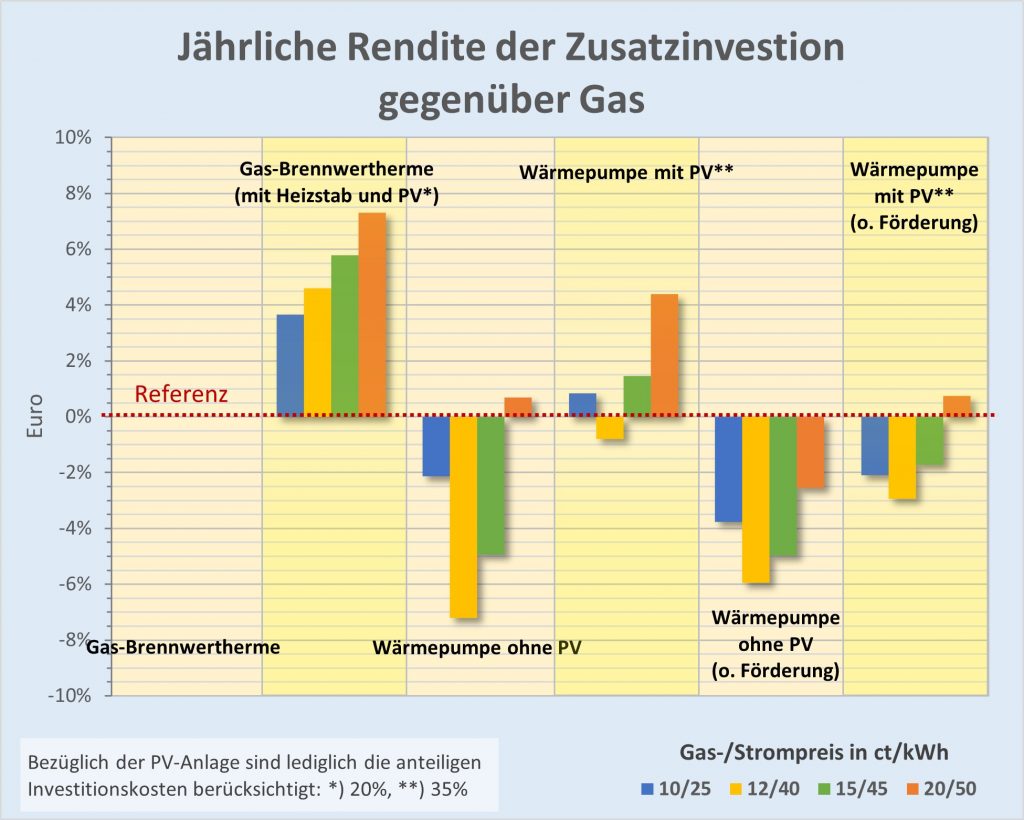

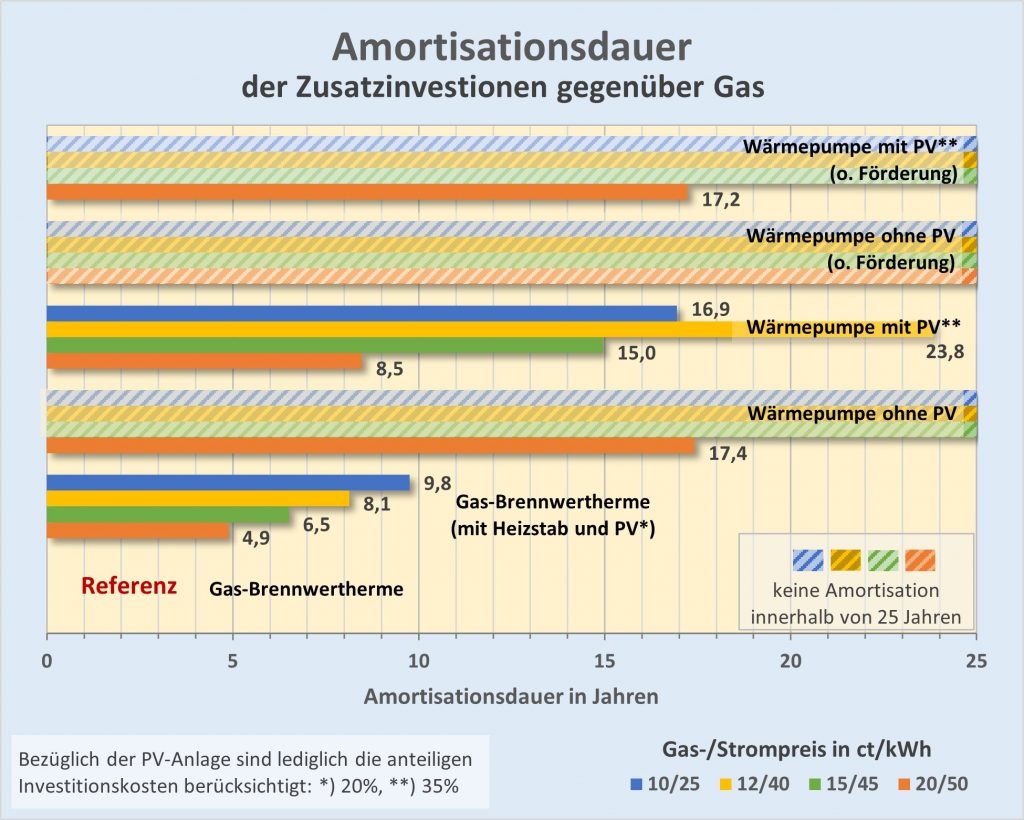

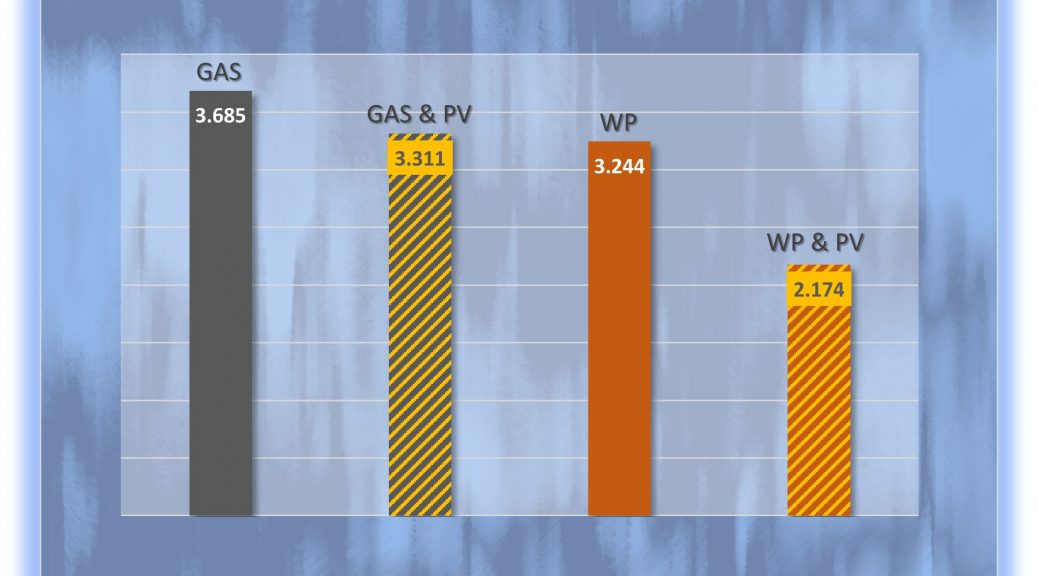

Mit dem vorgestellten Rüstzeug können wir nun die Wirtschaftlichkeitsbetrachtung für die durchgerechneten Bespielfälle aus Teil 4 (Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnu) mit und ohne Investition sowie mit und ohne PV-Stromnutzung zusammenfassend darstellen.

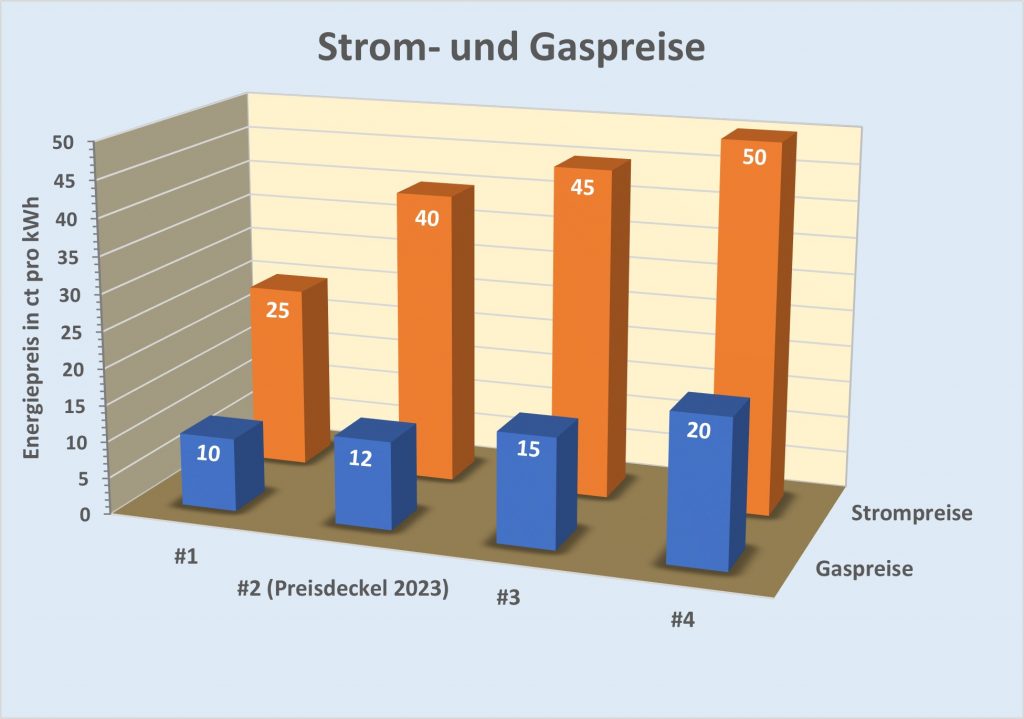

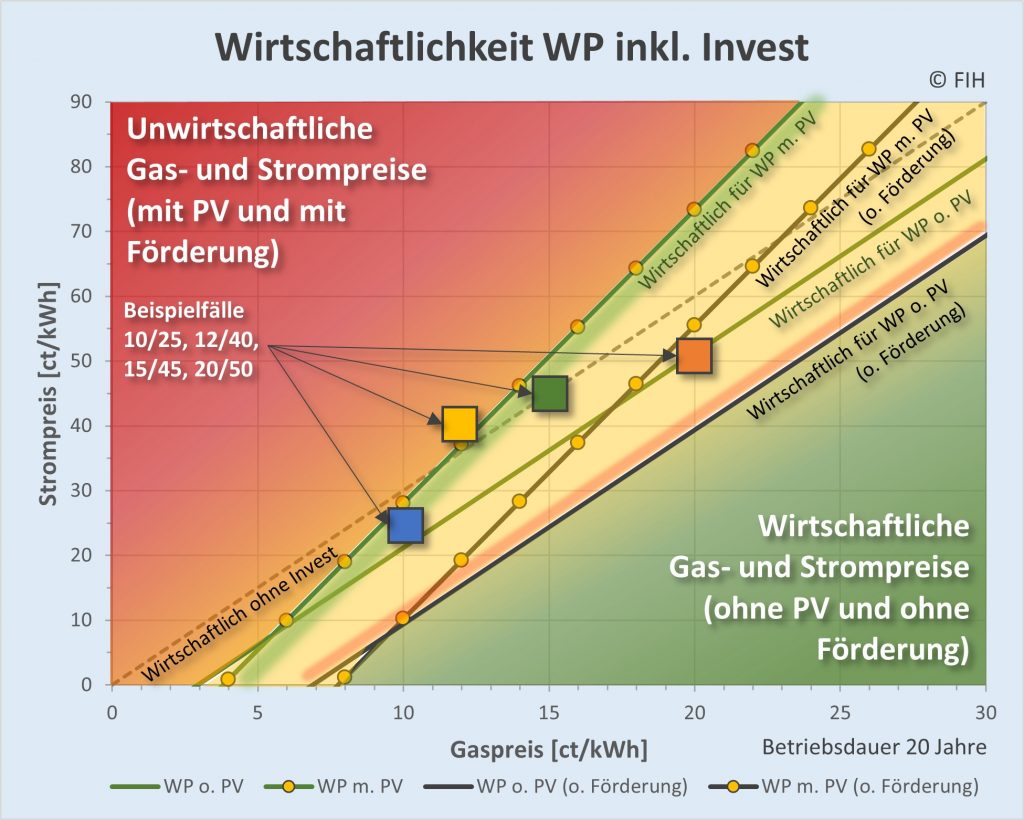

Abbildung 5-7: Wirtschaftlichkeitsbetrachtung für die in Teil 4 (Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnung) durchgerechneten Bespielfälle mit und ohne Investition sowie mit und ohne PV-Stromnutzung. Die Positionen der bespielhaft betrachteten Gas-/Strompreis-Kombinationen 10/25, 12/40, 15/45 und 20/50 ct pro kWh sind mit den entsprechend den obigen Diagrammen (s. Abb. 4-4 bis 4-12) eingefärbten Quadraten markiert. Rot dargestellt ist der Bereich der in jedem Falle unwirtschaftlichen Gas-Strompreis-Kombinationen. Der grüne Bereich rechts unten zeigt die stets – auch ohne Förderung – wirtschaftlichen Gas-/Strompreis-Kombinationen.

Die Bedeutung der in Abb. 5-7 eingetragenen Kurven ist im Diagramm erläutert. Z.B. trennt die gestrichelte Linie („Wirtschaftlich ohne Invest“) die wirtschaftlich sinnvollen (unterhalb) von den unwirtschaftlichen Strom- und Gaspreisen (oberhalb der Linie) unter ausschließlicher Betrachtung der Betriebskosten (ohne Invest). Die grüne Kurve mit den gelben Kreisen steht für die Trennlinie zwischen den ökonomischen (unterhalb der Linie) und den geschäftlich nachteiligen (oberhalb der Linie) Strom- und Gaspreiskombinationen unter Berücksichtigung der Betriebskosten einschließlich der Investitionen und der BAFA-Förderung.

Diskussion zur Wirtschaftlichkeitsanalyse

Mit Blick auf Abb. 5-7 zeigt sich die Gas-/Strompreis-Kombination 10/40 ct/kWh klar als unwirtschaftlich, 20/30 ct/kWh dagegen klar als wirtschaftlich. Wie man dem Diagramm ebenfalls entnehmen kann, waren bei den bis 2021 geltenden niedrigen Gaspreisen von 5 – 6 ct/kWh Wärmepumpen i. A. keine sinnvolle Investition, da zugleich die Strompreise bei mindestens 25 ct/kWh, also dem 4- bis 5-fachen davon lagen. Allenfalls waren reine Wärmepumpenstromtarife, die teilweise mit etwa 15 ct/kWh berechnet wurden bei ausschließlicher Betrachtung der Betriebskosten von Interesse.

Wie in der Grafik unschwer zu erkennen, liegt das gelbe Quadrat, das der Gas-/Strompreiskombination 12/40 ct/kWh entspricht, oberhalb aller eingezeichneten Geraden im roten Bereich der unwirtschaftlichen Gas- und Strompreise. Damit ist die aktuelle Gas-Strompreisbremse für eine Wärmepumpe mit einem COP von 3 in keinem Falle wirtschaftlich. Das gilt sogar ohne Berücksichtigung der Investitionskosten und bei PV-Stromnutzung. Damit ist weder die betrachtete Wärmepumpe ohne PV (durchgezogene grüne Gerade), noch mit PV (grüne, mit gelben Kreisen markierte Linie) wirtschaftlich zu betreiben.

Vorteilhafte Gas-/Strompreis-Kombinationen

Nur wenig besser sieht es aus für die Gas-/Strompreis-Kombination 15/45 ct/kWh (grünes Quadrat). Die Wirtschaftlichkeit ohne Berücksichtigung der Investitionen ist knapp gegeben (das Quadrat liegt knapp unter der gestrichelten Linie). Desgleichen gibt es ein Einsparungspotential in Bezug auf die geförderte Variante „Wärmepumpe mit PV“, da das Quadrat unterhalb der durchgezogenen grünen und mit gelben Kreisen markierten Geraden positioniert ist. Im Hinblick auf alle anderen Alternativen, „Wärmepumpe ohne PV“, sowie die nicht geförderten Varianten „Wärmepumpe mit PV“ und „Wärmepumpe ohne PV“ wird die Wirtschaftlichkeit klar verfehlt.

Etwas günstiger ist die Situation im Falle der Gas-/Strompreis-Kombination 10/25 ct/kWh (blaues Quadrat). Auch dieser Fall ist ökonomisch vernünftig bezüglich der reinen Betriebskosten und in Bezug auf die geförderte Alternative „Wärmepumpe mit PV“ inkl. der Investitionen (das blaue Quadrat liegt unterhalb der gestrichelten sowie der grünen Gerade mit Sonnensymbolen). Bezüglich der anderen geförderten Alternative, „Wärmepumpe ohne PV“ sowie der beiden nicht geförderten Varianten „Wärmepumpe mit PV“ und „Wärmepumpe ohne PV“ ist es indessen ein mehr oder weniger klares Draufzahlgeschäft.

Die beste wirtschaftliche Beurteilung kommt der Gas-/Strompreis-Kombination 20/50 ct/kWh (orangefarbenes Quadrat) zu. Diese Preisverortung ist akzeptabel sogar hinsichtlich der nicht geförderten Alternative „Wärmepumpe mit PV“ (durchgezogene dunkle Gerade, mit Sonnensymbolen markiert) und knapp positiv im Hinblick auf die geförderte Wärmepumpe ohne PV-Stromnutzung (blassgrüne Gerade). Einzig die nicht geförderte Variante „Wärmepumpe ohne PV“ (durchgezogene dunkle Gerade an der Grenze zum grünen Bereich) bleibt auch in diesem Falle eine ganz klar unwirtschaftliche Option.

Es hängt am Gaspreis. Und am Strompreis

Um noch zwei Beispiele herauszugreifen: Mit Blick auf Abb. 5-7 zeigt sich die Gas-/Strompreiskombination 10/40 ct/kWh als offenkundig unwirtschaftlich, 20/30 ct/kWh dagegen als eindeutig wirtschaftlich.

Aus der Diskussion ergibt sich nochmals in aller Deutlichkeit, dass die Frage pro und kontra Wirtschaftlichkeit bei gegebenem COP vor allem von den zugrunde gelegten Gaspreisen abhängt. Bei hohen Gaspreisen und halbwegs moderaten Strompreisen ist das Investment ökonomisch sinnvoll.

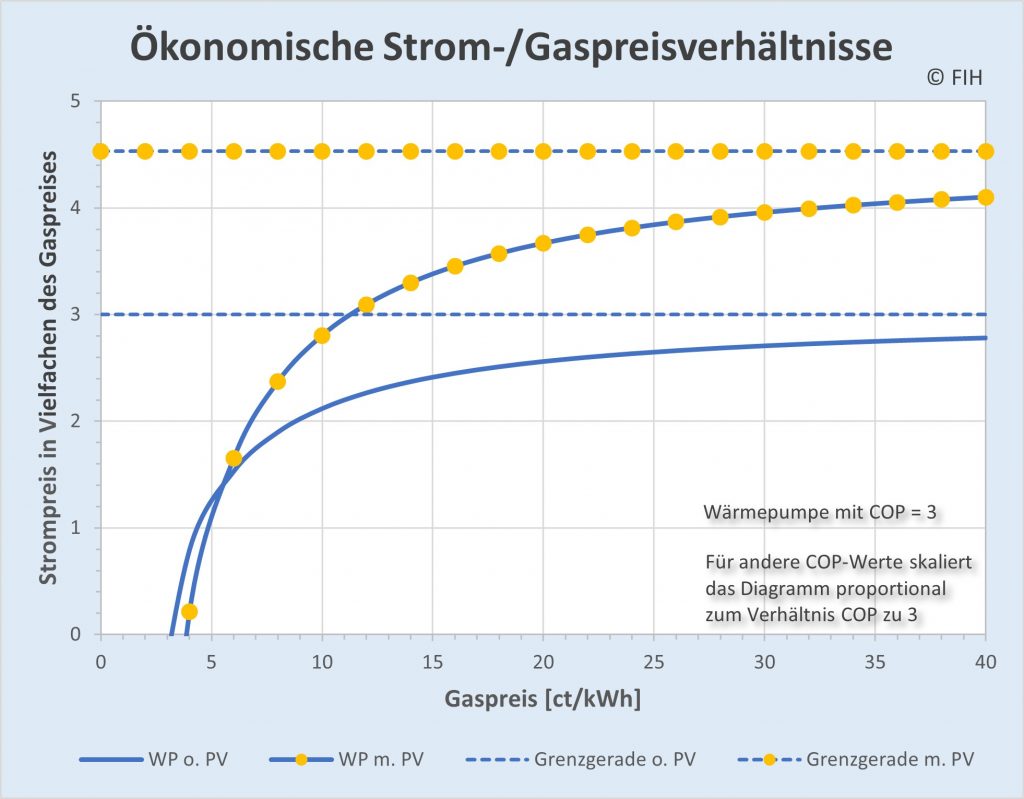

Sofern man keinen PV-Eigenstrom nutzen kann, sollte der Strompreis bei niedrigen Gaspreisen bis 15 ct/kWh weniger als zweimal so hoch sein als der Gaspreis. Bei höheren Gaspreisen darf der Faktor zweieinhalb kaum übersteigen. Wenn eine PV-Anlage vorhanden ist und etwa ein Drittel des Strombedarfs der Wärmepumpe darüber gedeckt werden kann, darf der Strompreis bei niedrigen Gaspreisen knapp das Dreifache erreichen. Liegt der Gaspreis darüber bei 15 bis 25 ct/kWh, sind teilweise auch Strompreise bis zum Dreieinhalbfachen des Gaspreises noch ökonomisch. Darüber hinaus dürfen die Strompreise gar das Vierfache des Gaspreises erreichen. In Abb. 5-6 ist der Zusammenhang dargestellt.

Abbildung 5-8: Wirtschaftlich sinnvolle Strom-Gaspreisverhältnisse für die durchgerechneten Beispielfälle unter Berücksichtigung der Investitionen (aus Teil 4 Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnung) und der optionalen PV-Stromnutzung von ca. einem Drittel des Strombedarfs der Wärmepumpe. Die durchgezogene blaue Kurve gibt an, um welchen maximalen Faktor der Strompreis über dem Gaspreis liegen darf. Den entsprechenden Faktor bei PV-Stromnutzung zeigt die mit gelben Kreisen markierte Kurve. Die beiden gestrichelten Linien stellen die theoretischen Grenzwerte ohne Investitionen bzw. bei sehr hohen (unendlichen) Gaspreisen dar.

Bei höheren Jahresverbrauchswerten verlaufen die durchgezogenen Kurven in Abb. 5-8 steiler, bei niedrigeren flacher. Umgekehrt verhält es sich bezüglich der Investitionen. Demnach müssen bei höheren Investitionen die Strompreise niedriger ausfallen, um einen noch wirtschaftlichen Betrieb zu ermöglichen. Dasselbe trifft zu bei niedrigeren Jahresverbräuchen.

Resümee

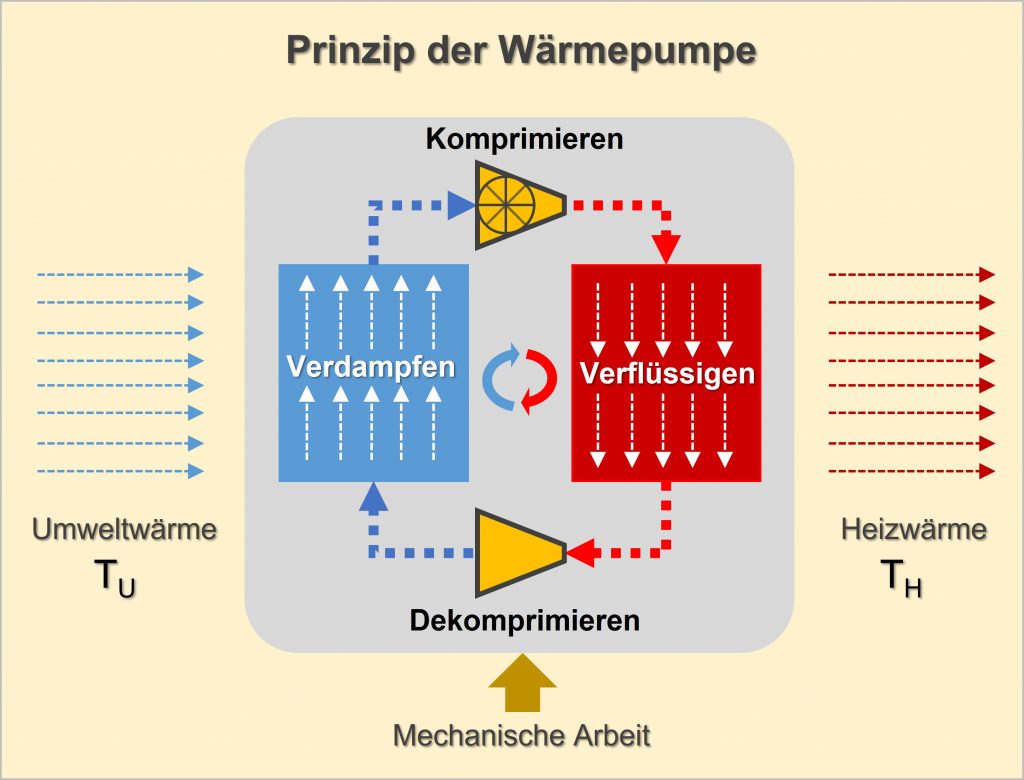

Ist nun eine Wärmepumpe der Gasheizung vorzuziehen oder nicht? Nach dem Vorstehenden und den vorangegangenen Analysen in Teil 2 (Wärmepumpe. Prinzip, Funktionsweise und Grenzen), Teil 3 (CO2-Emissionen von Gasheizung und Wärmepumpe – Vergleich für ein Bestandsgebäude) und Teil 4 (Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnung) kann man das Folgendermaßen beantworten:

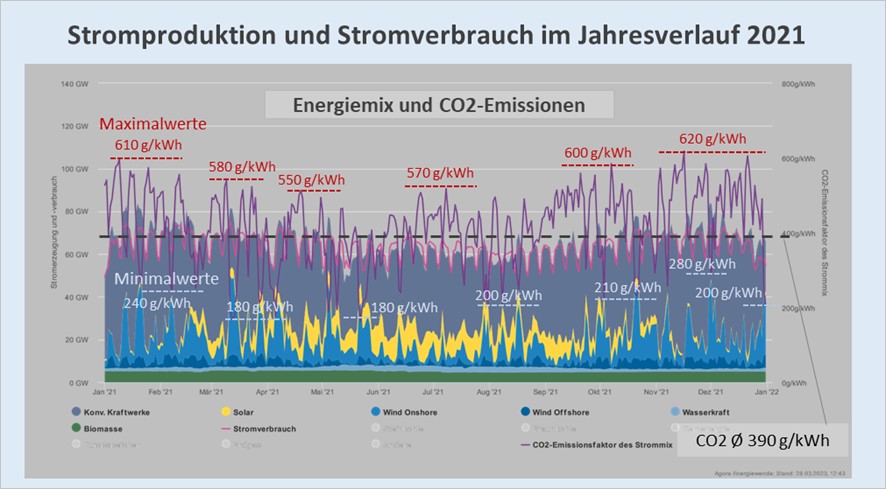

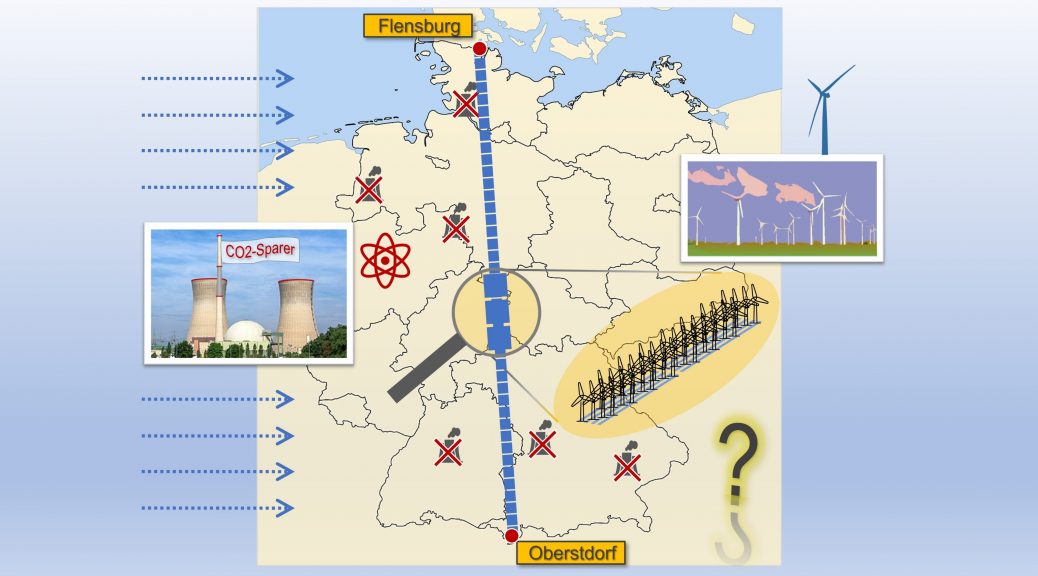

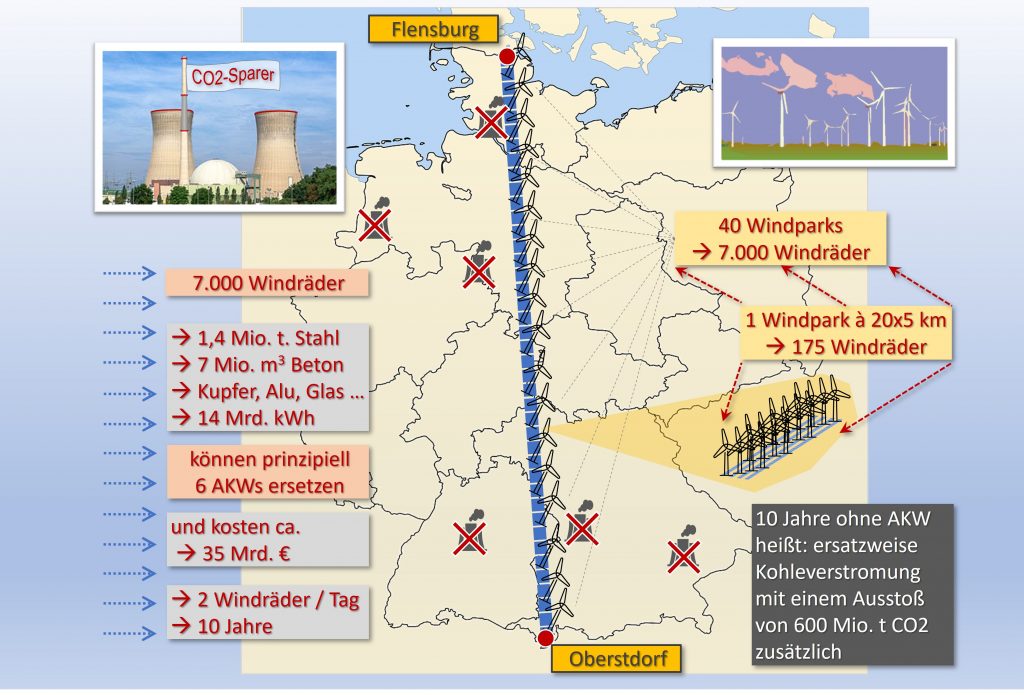

Aufgrund der hohen CO2-Emission im deutschen Strommix machen Wärmepumpen ohne PV gegenwärtig wenig Sinn. Sie sind nicht schädlich, bringen aber kaum nennenswerte Einsparungen in der CO2-Emission gegenüber Gas. Einen positiven Effekt gibt es mit PV, das allerdings erfordert höhere Investitionen. Sofern künftig CO2-freier oder zumindest merklich geringer mit CO2 belasteter Strom verfügbar sein sollte, sind Wärmepumpen von Vorteil, wenn die Investitionen niedrig gehalten werden können. Bei einem Verzicht auf die Kohleverstromung sind Wärmepumpen ein wertvoller Beitrag zur Wärmewende. Auf absehbare Zeit können indessen Windkraft und Solarstrom die Kohle nicht ohne Weiteres ersetzen.

In der ökonomischen Perspektive – und die kann und darf man nicht ausblenden, wenn man das Ziel einer klimapolitischen Wirkung ernsthaft verfolgen will – sind drei Faktoren von entscheidender Bedeutung:

1. Die Höhe der erforderlichen Zusatzinvestitionen gegenüber einer Gasheizung.

2. Die Möglichkeit der Nutzung von Solarstrom.

3. Das Verhältnis Strompreis zu Gaspreis.

Sofern der auf die Anzahl der Betriebsjahre umgelegte Investitionsbetrag den Bruchteil der Jahresverbrauchskosten an Heizenergie (mit Gas) nicht überschreitet und kein Solarstrom zur Verfügung steht, genügt es, wenn der COP-Wert der Wärmepumpe um den Faktor

größer ist als das Verhältnis Strompreis zu Gaspreis (x = 2, 3, 4, 5, …). Ansonsten ist der Einsatz i. A. nicht wirtschaftlich. Mit einem Solarstromanteil von

gilt dasselbe für das Verhältnis des mit dem Faktor

multiplizierten Strompreises zum Gaspreis. Wenn die umgelegten Zusatzinvestitionen pro Betriebsjahr ungefähr die Höhe der Jahresverbrauchskosten erreichen oder gar überschreiten, ist die Wärmepumpe definitiv unwirtschaftlich. In den Fällen dazwischen muss man Formel (6) oder (8) genau auswerten.

Ausblick auf Teil 6

Ist die Wärmepumpe zum jetzigen Zeitpunkt das richtige Heizsystem für Deutschland? Macht ein Verbot bzw. ein Tauschzwang für Gasheizungen Sinn? Und ist der finanzielle Aufwand dafür unter allen Gesichtspunkten – wirtschaftlich und klimapolitisch – vernünftig?

Es wird gezeigt, dass der Einsatz von Luft-Wasser-Wärmepumpen unter den gegebenen Umständen in der großen Perspektive weder wirtschaftlich ist noch überhaupt eine nennenswerte klimapolitische Wirkung entfaltet. Darüber hinaus wird dargelegt, mit welchen Maßnahmen die CO2-Emissionen wirksam und effizient reduziert werden können.

Link: Wärmepumpen für Deutschland – Klimapolitisch sinnvoll oder Fehlinvestition?

Alle Beiträge der Reihe:

1. Energiewende, Stromproduktion und CO2-Emission

2. Wärmepumpe. Prinzip, Funktionsweise und Grenzen

3. CO2-Emissionen von Gasheizung und Wärmepumpe – Vergleich für ein Bestandsgebäude

4. Gasheizung oder Wärmepumpe? Exemplarische Wirtschaftlichkeitsrechnung

5. Grundsätzliche Analyse zur Wirtschaftlichkeit von Wärmepumpen

6. Wärmepumpen für Deutschland – Klimapolitisch sinnvoll oder Fehlinvestition?